最近の記事

論文紹介: LLaVA-1.5 (Improved Baselines with Visual Instruction Tuning)

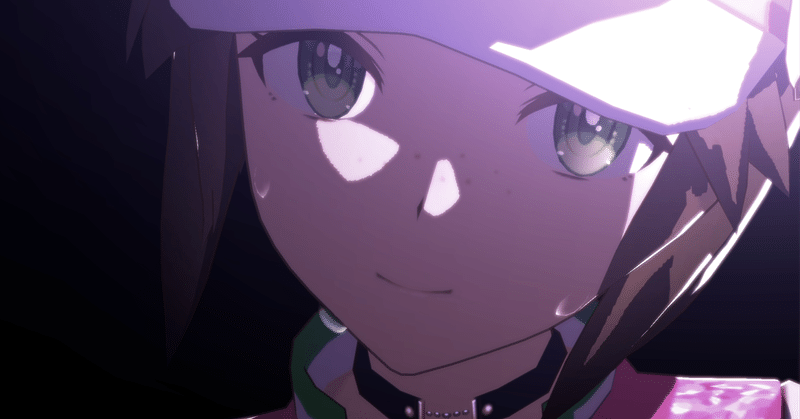

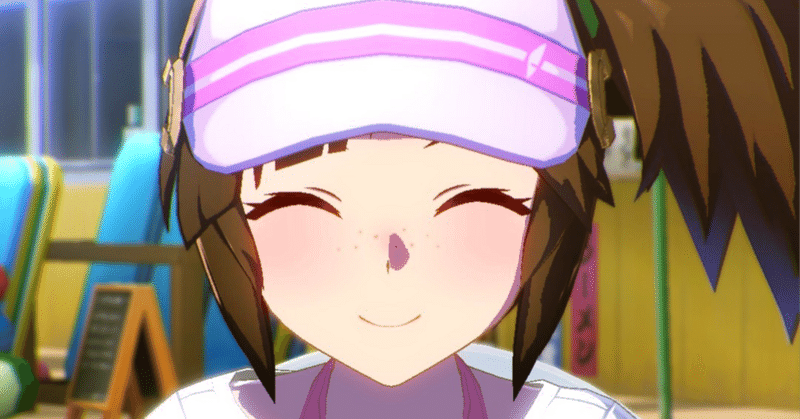

昨日、LLaVA-1.5が発表されましたね。 LLaVA-1.5は、今まで公開されているV&Lモデルの中で、初めて以下のスクリーンショットからそれぞれのキャラの順位を正しく答えることができました。 また、このイベントは5回戦で1セットなのですが、5回中何回勝利したか、またレース中のスクリーンショットから、自分のキャラが今何番手かを回答することもできました。 驚くべき性能を発揮するLLaVA-1.5が、どのような工夫をしたのかが気になったので、今回はLLaVA-1.5の論