#7 AI歌声合成と楽譜の問題

VOCALOIDやVX-βでの歌声制作に触れて、歌唱を五線譜に記譜するという次元ではなく、五線譜よりもより精細な情報を書き込めるノート・データの次元で考えるようになりました。

以降は、歌唱をノート・データで記述する経験の中で、自分なりに考えたことを書き連ねたものです。

VX-βでの歌声制作に役立つ内容ではありませんので、ご興味のある方だけお読みくださればと思います。

X(旧Twitter)で書き込んだか、書き込もうとした文を改めて書き直したものです。

1. 符号化(エンコード)と復号化(デコード)

音声言語(話しコトバ)が文字(書きコトバ)として固定されたように、音楽や歌声が楽譜に固定されたという歴史があります。

「音声言語→文字」であるように「(演奏された)音楽→楽譜」という順序だったはずです。

やがて、その順序を逆さまにして、「(台本として書かれた)文字→(セリフとして発せられる)音声言語」や「(作曲された)楽譜→(その楽譜を歌った)歌声」ということもなされるようになります。

これを現代的な情報処理の用語でいうと、次のようになろうかと思います。

「音声言語→文字」「音楽→楽譜」 = 符号化(エンコード)

「文字→音声言語」「楽譜→音楽」 = 復号化(デコード)

音声合成AIがやろうとしていることは、その逆さまの順序、つまり、復号化ということになります。

現代の音楽は、楽譜や音楽理論に基づいて作曲され、演奏されるのが当たり前になりすぎたため、原始の本来的な音楽の在り方がわかりにくくなっているように思えます。

音楽は、有史以前から「自律的に」存在し、伝承・発展してきました(なので、音楽の始まりがどのようなものであったのかは史料からは特定できません)。

楽譜や音楽理論なるものは、自律的に伝承・発展してきた音楽の実態に基づいて、各地で整備されてきたものに過ぎません。

五線譜以外の楽譜も存在しますし、西洋音楽理論以外にも各地の民族音楽の音楽理論が存在します。

また、文字を持たない言語が存在するように、楽譜や音楽理論を持たない民族音楽も存在します。

音楽が先で、楽譜/音楽理論が後であることは自明で、「卵が先か鶏が先か」のような議論の余地はありません。

2. 楽譜が文字とは異なる点

「音声言語と文字」については、誰しもが「音声言語→文字」「文字→音声言語」の双方を自在に操れるよう訓練(教育)されます。

つまり、誰しもが符号化でき、復号化できます。

なので、「音声言語→文字(音声認識)」と「文字→音声言語(音声合成)」の双方が研究の俎上に乗っていますし、 私たちはすでに、音声認識と音声合成の双方に慣れ親しんでもいます。

符号化と復号化の双方が車の両輪のように研究されているように思えます。

しかし、「音楽と楽譜」となると、誰しもが「音楽→楽譜」「楽譜→音楽」の双方を自在に操れるわけではありません。

それでも、「楽譜→音楽(歌声/演奏)」については、義務教育における音楽教育の中でいくらか触れることになりますし、楽器演奏ができる人は比較的多いので「楽譜→音楽」ができる人は比較的多くいると思われます。

けれども、「音楽→楽譜(いわゆる「耳コピー」)」となると、かなりの音楽的な訓練を積んだ人でなければできません。

たいていの人はそもそも、「耳コピー」をしたいとも思いません。

つまり、復号化できる人はそれなりに多くいるけれども、符号化できる人はかなり少ないということになります。

そのようなことを背景に、「楽譜→歌声(歌声合成)」の研究だけが先行し、「歌声→楽譜(歌声認識)」の研究が立ち遅れているのかもしれません。

「音楽→楽譜」の符号化のカラクリが未解明のまま、「楽譜→音楽」の復号化の研究だけが進んでいるとも言えます。

3. 歌声/演奏の符号化(MIDIデータ化・楽譜化)

とはいえ、音楽(歌声/演奏)の符号化の研究は、楽譜とは少し距離を置いた形で実用化されています。

1) 耳コピーソフトウェア

「耳コピー」を自動で行いたい需要は一定数あるので、楽曲のwavデータをMIDIデータに変換するソフトウェアが実用化されています。

そのような「耳コピー」ソフトウェアでは、ピアノやギターといった「音の立ち上がりが明瞭で」「ピッチが安定した」楽器の音は、かなりの精度で「耳コピー」してくれるようです。

しかし、歌声のような「音の立ち上がりが不明瞭で」「ピッチが不安定な」音は、うまく「耳コピー」ができないようです。

ただし、それらの変換は、MIDIデータに変換するに留まり、楽譜への変換は行いません。

MIDIデータに変換するとは、wavデータ内に存在するさまざまな楽音を12平均律で近似したノート・データに変換するということです。

なので、拍節とずれて演奏している箇所があれば、拍節とずれたノート・データに変換されます。

そのようなMIDIデータを楽譜化するには、なんらかの形で拍節のタイミングにきっかりと合わせる「クオンタイズ(量子化)」が必要になります。

●拍子とテンポを検出する困難さ

テンポが一定でない楽曲では、楽曲のwavデータから、拍子とテンポを検出しなければなりません。

拍子とテンポが適切に検出できなければ、そもそもの基準点がずれてしまうので、適切な楽譜にはなりません。

楽曲が次のような箇所を含む場合、拍子とテンポの検出は著しく難しくなります(人間が耳コピーするにしても相当に難しい)。

・fermata(音符の長さを任意の長さに伸ばす)

・ritenuto(テンポを一時的に急に落とす)

・tempo rubato(拍節とずれて演奏する)/tempo ad lib.(自由なテンポで演奏する)

・変拍子(小節ごとに拍子が変わる)/無拍子(拍子がそもそも存在しない:協奏曲のCadenzaなど)

自動採譜の最大の困難は、拍節とテンポの検出にあるのではないかと思います。

2) ピッチ補正ソフトウェア

歌声のピッチやリズムを修正したいという需要はとても多く、Celemony社の「Melodyne」のようなピッチ補正ソフトが実用化されて久しいです。

ピッチ補正ソフトにおける歌声の自動解析は、おおむね次のようなアルゴリズムで行われます。

1. ピッチ変化や音量変化の大きい箇所(トランジェント)を音符と音符との境界であると推定する。

2. 1つの音符であると推定された範囲のピッチの平均を音符の音高として推定する。

ただし、そのように推定された各音符は、拍節ともずれているし、12平均律からも外れています。

一般的な楽譜の形にするには、なんらかの形で拍節のクオンタイズをするだけではなく、12平均律へのピッチ・クオンタイズも必要になります。

4. 楽譜/記譜の暗黙のルール

一般的な「楽譜」なるものは、なにかよくわからない暗黙のルールで符号化されています。

実際の音楽(歌声/演奏)が拍節からずれていようが、正しいピッチから外れていようが、拍節と12平均律の格子の中に閉じ込めて簡略化する慣わしになっているのです。

なぜ、そのような簡略化をするのかというと、簡略化をしておかないと瞬時に楽譜を読めないからです(※)。

とはいえ、楽譜をどう簡略化するのかには、明確なルールはありません。

なので、楽譜に基づかない音楽(民謡や即興演奏など)を採譜するときには、多かれ少なかれ採譜者によってばらつきが出ます。

「音楽→楽譜」の符号化(採譜)は、「音声言語→文字」の符号化(文字起こし)よりも、はるかに曖昧なのです。

(※)瞬時に読めない複雑な楽譜は、とてつもない時間をかけて解読し、その解読したものを丸暗記するしかなくなります。そうなると、師匠の歌声を丸暗記して、真似て歌うのと大差がないことになります。

師匠の歌声は直感的に理解することができますが、複雑な楽譜はどうにか理解できるように解読しなければなりません。しかも、現代では師匠の歌声を録音することもできるので、どう考えても「師匠の歌だけで事足りるんじゃね?」となります。

とはいえ、新たに作曲・記譜された音楽には「師匠の歌声/演奏」は存在しないので、やたらと複雑な楽譜であってもワンチャンスあるように思えます。しかし、やたらと複雑な楽譜を演奏したがる人は極めて稀なので、現実的には限りなくノーチャンスになるのです。

5. 作曲家の脳みそを考える

それらを踏まえた上で「作曲家」というケッタイな人たちの頭ン中はどーなっているのかを考えてみます。

少なくとも、自分の脳みそには、次の2つのモードがあるように思えます。

1. 音符を並べて(音組織)構成するモード(和声付けとか、編曲をする脳みそ)。

2. 実際の演奏(歌唱)をイメージして採譜するモード (鼻歌を歌ってみて、それを採譜する脳みそ)。

問題は、2.で、このときの「採譜」は、実際の演奏のイメージを一般的な楽譜の形に落とし込んでいます。

最初の話に戻すと「音楽(歌声/演奏)→楽譜」ということをやっています。

なぜ、一般的な楽譜の形に落とし込むのかというと、1.の編曲に繋ぐことができないのです。

編曲というのは楽曲の全体を設計する作業なので、細かな演奏のニュアンスは一旦切り捨て、建築物の構造計算みたいなものをします。

音楽という構造物が、きちんとバランスよく成立するかどうかだけを吟味するわけです。

とはいえ、実際の音楽(歌声/演奏) となると話は別で、細かなニュアンスも大事になってきます。

建築でたとえるなら、構造計算なしには大きな建築物は建ちませんが、建っていればなんでもいいわけというわけではありません。

建築物では、外装・内装・装飾といった細部こそが重要な要素となります。

音楽も同様に、歌声/演奏の細かなニュアンスが重要な要素となります。

6. AI歌声合成と楽譜との矛盾

以上の点を踏まえると、AI歌声合成はある種の矛盾を抱えているように思われます。

AIが「楽譜」と「その楽譜を歌った歌唱音声」との対応を学習している場合、そのAIは、「楽譜上の正しい拍・正しいピッチ」と「実際の歌唱」とのズレを学習していることになります。

しかしながら、楽譜そのものが曖昧でアヤフヤなものなのだとすると、そのAIは、一体なにを学習したことになるのでしょうか。

「音楽→楽譜」という符号化の曖昧さの問題が、亡霊のように浮かび上がってきます。

1) ジャズの歌唱文化を考える

たとえば、ジャズのスタンダート・ナンバーと呼ばれる楽曲の多くは、作曲者による正規の楽譜が出版されているので、楽譜の曖昧さはなく、固定化されています。

けれども、実際の歌唱となると千差万別であって、元の楽譜を自由に変更して歌うことが許容されますし、推奨されてもいます。

また、同じ歌手が同じメロディを歌うにしても、毎回、違ったふうに歌うことがごく普通に行われています。

ジャズの歌唱文化の興味深いところは、高名な歌手の歌唱(の録音)を採譜する人たちが存在することです。

たとえば、『Amazing Grace』の楽譜(採譜)には、実にさまざまなバージョンがあります。

『Amazing Grace』を歌い継ぐ後進の歌手たちは、先人の歌手たちの「歌唱の録音」を参照したり、その「採譜」を参照して、自らの歌い方を作り上げていきます。

もっと突っ込んだ言い方をすると、楽譜を介することなく、実際の歌唱に基づいて「口伝」で歌い継いでいるとも言えるわけです。

このような「口伝」による音楽の伝承は、楽譜化されて固定化される以前の本来的な「歌」の姿であるとも言えます。

このような「口伝」の歌唱を想定するとき、AI歌声合成はどのようなスタンスをとるべきなのでしょうか。

少し立ち止まって考える必要があるように思われます。

2) AI歌声合成の岐路

楽譜という曖昧でアヤフヤなものに対して、AI歌声合成技術が向かうべき方向性は、おそらく2つの方向性があるように思います。

1. 簡略化された楽譜から、直接、人間歌唱のような複雑な歌声を合成する。

細かなピッチ変化はもちろん、細かな抑揚や、アドリブ的に楽譜を少し崩したフレーズまでもを全自動で合成する。

2. 簡略化された楽譜からは、その楽譜を素直に歌った歌声しか合成しない。

複雑な歌声を歌わせたいときは、細かなメリスマを採譜したかのような複雑な楽譜を用意し、どのような抑揚で歌わせたいかについては緻密な演奏データを用意する。

1.の方向性は、「楽譜→歌声」の復号化の精度を人間の歌手と同程度に高めようというものになります。

したがって、AI歌声合成技術は、さまざまな歌手の歌い方の個性を完全にトレースしていくことが目的となります。

Aという歌手が「楽譜→歌声」の復号化をすると(楽譜を歌うと)こうなる、Bという歌手が「楽譜→歌声」の復号化をするとこうなる…というのを目指すことになります。

この方向性は「AI歌声合成技術=歌手の代替」を志向することになります。

2.の方向性は、「楽譜→歌声」の復号化はシンプルな形に留める代わりに、歌声の細かな表現は「演奏家(演奏データの作成者)」に委ねようというスタンスです。

したがって、AI歌声合成技術は、さまざまな「演奏家」の求めに応じて、さまざまな歌声が合成できるように、より演奏しやすいように最適化することが目的となります。

この方向性は「AI歌声合成技術=楽器としての歌声」を志向することになります。

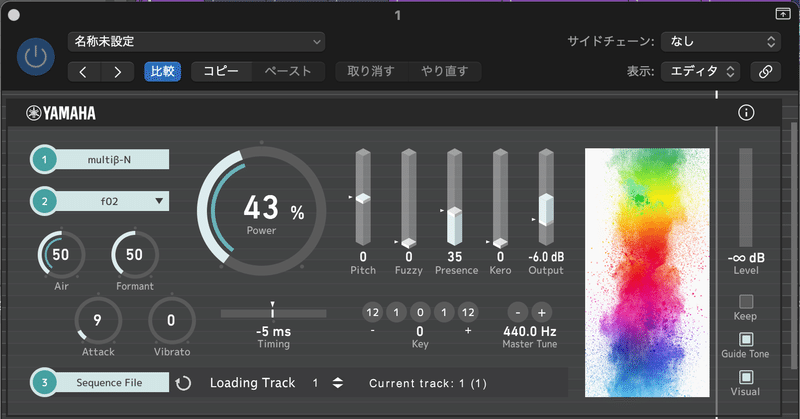

個人的には、CeVIO/neutrinoは1.の方向性、VOCALOID/VX-βは2.の方向性、SynthesizerVは1.と2.の折衷というイメージがあります。

なので、これらは互いに棲み分けていくんじゃないかな…と勝手に想像しています。

VX-βはそういう意味で、オープンβという形で公開されたことは、意義深いことのように思えます。

VX-βが「楽器としての歌声」を志向するのであれば、さまざまな「演奏家(演奏データの作成者)」の「求め」なしには、最適化のしようがないからです。

なので、VX-βの試奏に参加された方は、「もっとこうしたいんだけど、うまくいかないんだよねー」とか、「こういう機能があれば、もっと扱いやすくなるのになー」とか、あれやこれやと開発者たちに「求め」てみるとよいと思います。

いずれの方向性であれ、現状においては、拍節のタイミングにぴったりとあった歌声合成が求められることになります。

歌手が伴奏トラックのテンポ・拍節・和声を感じて歌うように、AIが伴奏トラックを解釈して、適切なグルーブ(ノリ)・拍節とのズレ・和声を踏まえた上でのアドリブを伴った歌声を生成できるのが理想なのかもしれませんが、そうはなりません。

現段階では、伴奏トラックからテンポ・拍節・和声を適切に検知することは非常に困難だからです。

7. 歌声合成はどのような役割を果たすことができるのか

さらに、個人的な見解を述べますと、歌声合成がソロ・シンガーの代替となることはないように思えます。

現状では、ソロ・シンガーに宅録を依頼するコストと、歌声合成をソロ・シンガーに匹敵するような歌声に調整するコスト(=作業時間)を考えると、後者のほうが時間がかかる上、結局はコストが高くつきます。

ここのコストが逆転しないうちは、ソロ・シンガーの仕事が奪われることはなさそうです。

歌声合成がソロ・シンガーの代替とはならないとき、歌声合成はどのような役割を果たすことができるのでしょうか。

その明確な答えは持っていませんが、いくつかの方向性を考えることができると思います。

1. 人間のソロ・シンガーには不可能なソロ・シンガー

いろいろな要素が考えられますが、VOCALOIDの黎明期に開拓された領域でもあります。

・(Vocoderを代替するような)不自然でぎこちない歌声

・息継ぎを不要とする、広大な声域を持った歌声

・楽器音の代替としての歌声 例)Nyan Cat『NyaNyaNyaNyaNya』

2. 合唱

・ 少人数の合唱

・ 少人数の斉唱

・人間のソロ・シンガーのバック・コーラス

3. 人間には歌ってもらえない歌声

・人間歌唱で実現するには膨大なリハーサルを要するもの(やたらと難しいパッセージ/ハーモニー)

・人間歌唱で実現するには人間にとってあまりにも面白みがないもの(歌声によるミニマル音楽/器楽的に作曲された歌曲)

・誰が歌っているのかわからなくなるほどの、過度なエフェクト処理を前提とする歌声

4. 仮歌

「仮歌の仮歌」がもっとも実践的な用途かもしれない。

・仮歌(歌手に歌唱イメージを伝えるためのデモ演奏、モックアップ)

・仮歌の仮歌(歌詞を考えたり、伴奏トラックを考えるための仮歌)

この記事が気に入ったらサポートをしてみませんか?