ディープフェイクの罠: ビデオ通話の安全神話を超えて

1.ディープフェイク技術の広がりとリスク

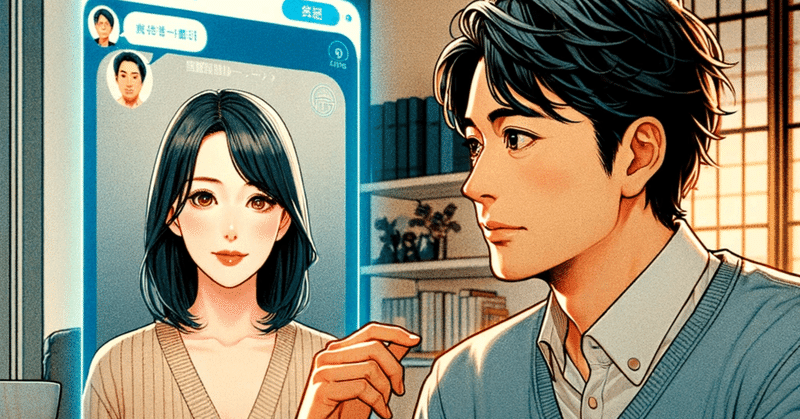

ディープフェイク技術は、AIと機械学習を用いて実在する人物の顔や声を別の映像や音声に合成する技術であり、近年、その技術の進化とアクセスの容易さが顕著になっています。オーストラリアのカサンドラ・クロス教授(資料1)が指摘するように、この技術は既に国際ロマンス詐欺や投資詐欺に広く使われています。犯罪者たちはこの技術を悪用して、ビデオ通話上で自分の顔を他人の顔に偽装することができ、このリアリティが被害者を欺く新たな手口として用いられています。その結果、ディープフェイクはオンライン上での人間関係や信頼を根底から揺るがす新たな脅威となっています。

2. 被害者の錯覚と詐欺師の偽装

ニュース番組において、専門家の見解として「ビデオ通話をすれば安全」というアドバイスが報道されると、被害者がビデオ通話を通じて相手の顔を確認することで、その人物が実際に存在し、誠実であるという誤った錯覚を抱くリスクを高めます。ディープフェイク技術の進化により、詐欺師は自らの偽装をより巧妙に、説得力を持って行うことが可能になり、被害者は見た目による判断を信頼しやすくなります。この錯覚は、特にオンライン上の関係性に慣れていない中高年層にとって、詐欺師の言葉を信じ込みやすい土壌を作り上げます。

実例として自らの国際ロマンス詐欺の経験を漫画や文章でつづっておられる漫画家の井出智香恵のケースを挙げます。井出氏はインターネットで知り合って恋愛関係になった偽のマーク・ラファロがディープフェイクを使っていたことを被害後に知り、その件についていくつものインタビューなどで述べています。井出氏のインタビュー記事には、偽のラファロ氏が写ったパソコンの画面の写真が掲載されており、ディープフェイクでなりすましの人物がビデオ通話をするということは実は非常に容易なことであることがわかります。(資料2,3)

3. 重要な情報が省略される問題点

報道機関には、公衆を啓蒙し、正確な情報を提供する責任があります。ITやインターネット犯罪などに詳しい専門家であれば、ディープフェイクのことはよくご存知のはずです。しかし、2024年3月8日に日本テレビのニュース番組で報道された内容「時間かけて恋愛感情を……“ロマンス詐欺”急増、対面せず「3億6000万円」被害も 狙われやすい世代は? 対策はビデオ通話」は、テレビ局の尺の関係でその専門家の見解がフルに報道されておらず、結果として視聴者にディープフェイクのリスクに関する重要な情報が報道で伝えられていませんでした。この情報の欠如は、視聴者がオンラインでの交流における実際の危険性を十分に認識できない状況を生み出し、結果として誤った「対策としてビデオ通話が有効、ビデオ通話ができたから大丈夫」という誤った安全感を抱かせることに繋がります。(資料4)

4. 視聴者への誤った安全感と報道の責任

ニュース番組によって提供される情報は、特に重要な問題に関しては、正確で包括的でなければなりません。「ビデオ通話が国際ロマンス詐欺を防ぐ確実な手段である」という誤解を広めることは、特にディープフェイクのような新たな技術的脅威が存在する現代において、非常に危険です。報道機関は、ディープフェイクのリスクを含めたオンライン詐欺の全容を明らかにし、視聴者に対してより現実的な警告と保護策を提供する責任があります。こうすることで、公衆が情報に基づいた意思決定を行い、自身を守るための適切な手段を講じることができるようになります。

References:

資料1(カサンドラ・クロスの論文)

(1)Cross, C. Using artificial intelligence (AI) and deepfakes to deceive victims: the need to rethink current romance fraud prevention messaging. Crime Prev Community Saf 24, 30–41 (2022).

資料2(井出智香恵 産経新聞記事)

資料3(井出智香恵 文春オンライン記事)

資料4(日本テレビニュース 2024年3月8日)

この記事が気に入ったらサポートをしてみませんか?