TS-859 に RAID6 を組む

(この記事は 2021年7~8月 くらいの情報です)

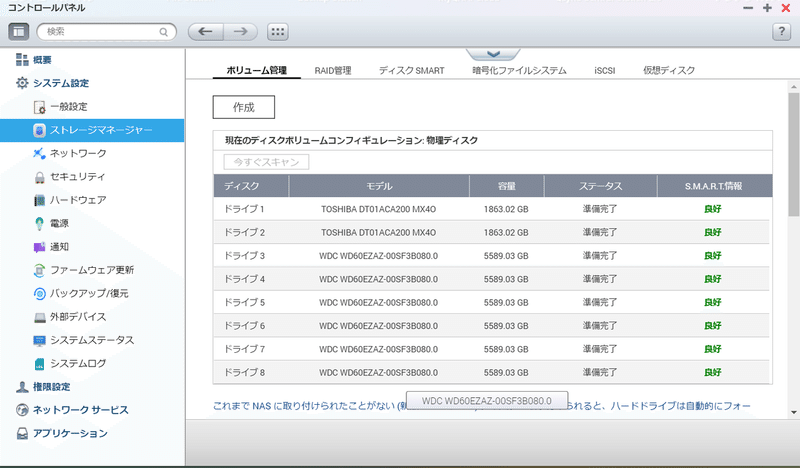

空いている TS-859 に HDD を8台ブチ込み、RAID6 を構成します。

その顛末。

というかまだ途中だけど。

今回の反省を最初に言うと、HDD は最初から「データ消してもいい CMR」を8台用意しましょう。ってことで。

ほぼ待ち時間だけど、検証長すぎますー

8ベイ NAS の有効活用

先日やっとメインを TS-473 に移した&RAID0 の不調も解消して再運用開始しました。

色々あって、自動振り分けは残り容量を見るように修正しました。

df -m の結果を切り出して数値比較するだけなのでコードは割愛。

そして、完全に余って UPS ドライバと化している TS-859 をきちんと RAID6 ドライブとして使うことにしていきます。

「偶然」手元に WD Blue の 6TB が8台あるので、これを使っていこうと思います。

(ポイント高還元の時にちまちま買ってたら揃ってた)

SMR だけど「全部 SMR で揃えれば動く」という話もあるので挑戦してみることにします。

(そこでの検証は、一部だけ SMR だと書込速度遅延でエラードライブ扱いされちゃうので NG、という話だった)

本当は RD Red の 14TB で組むつもりだったんだけど、5月に安かった頃に何台か注文したのがまだ届かないので諦め。

東芝の MN08CA14T とか夏のPayPay祭の時に買えば実質3万/台くらいだったので、発注してあるの全キャンセルして新規に8台揃えちゃってもよかったんだけど、今更ねぇ…

お題

RAID6 を運用するにあたって、事前にいくつかテストしておく予定。

1)障害時を模した、ディスク1台交換シナリオ

2)同、2台同時交換シナリオ

3)ディスク追加による容量拡張

4)ディスク全交換による容量変更

このうち、4は必要なディスク揃わないので諦めるとして、1~3 は運用開始前にやってしまっておきたいところ。

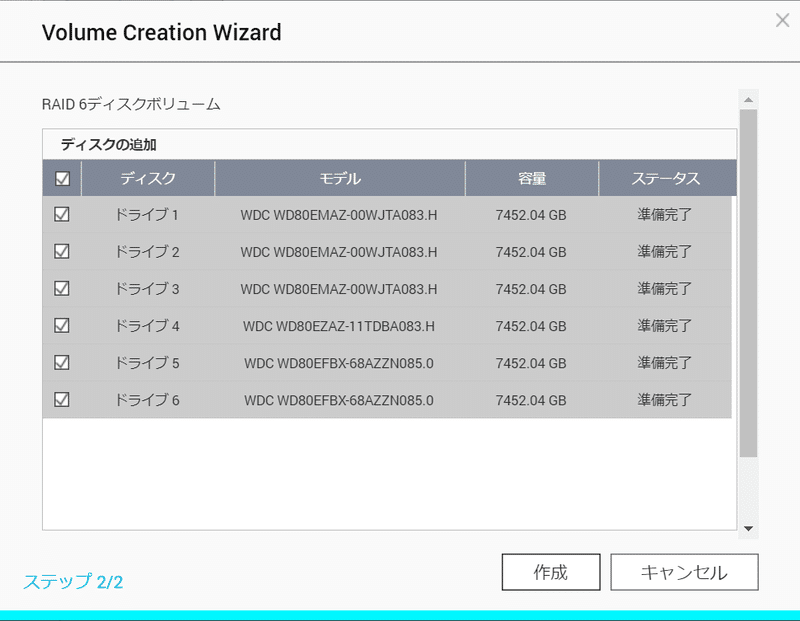

RAID6 を構築する

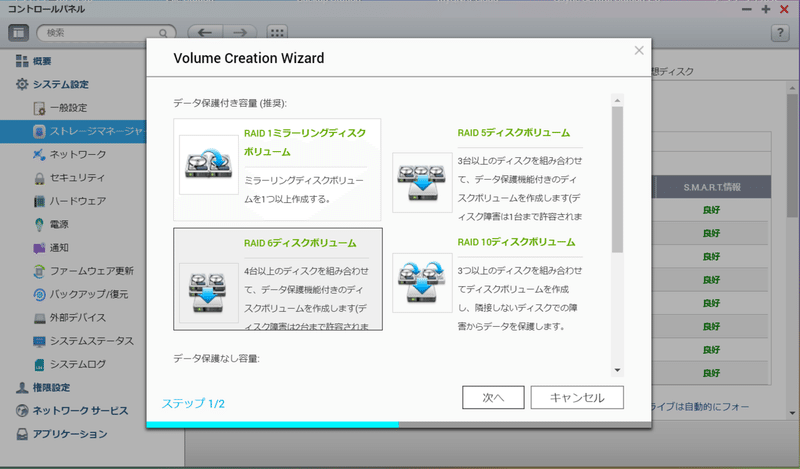

QNAP の RAID 構築はとても簡単です。

TS-859 Pro+ は QTS のバージョンが 4.2.6 が上限ですが、現行の 4.5 でも流れはそんなに変わらないです。

(ストレージプールを作るあたりが違う程度)

空いているベイにつっこんで

RAID 作成をぽちぽちするだけ。

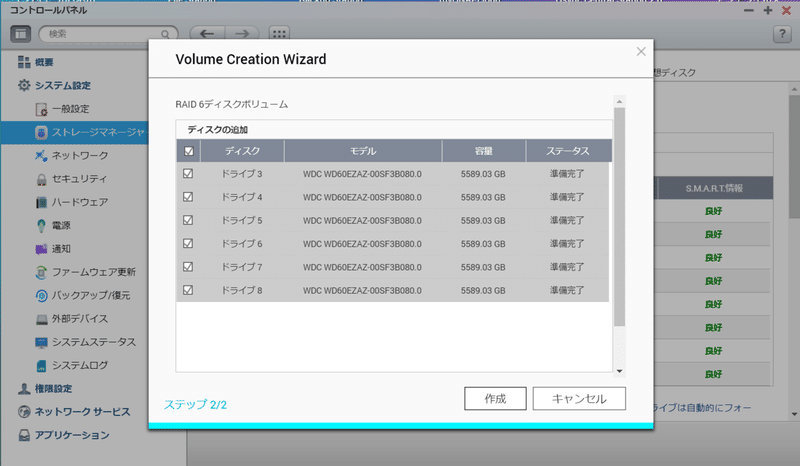

「ディスク全部一度に抜くと設定消える」性質と、今後のテストの為に、とりあえず6台で進めます。

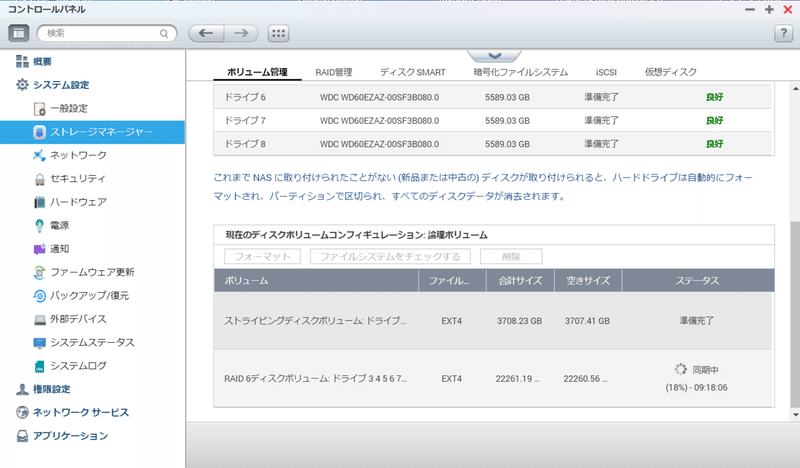

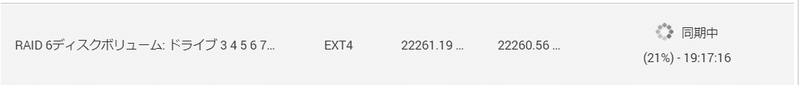

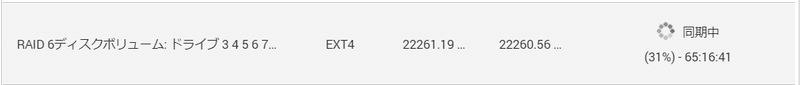

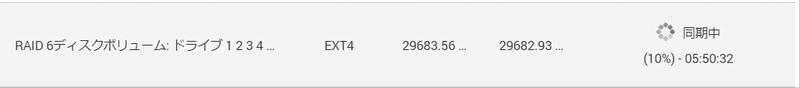

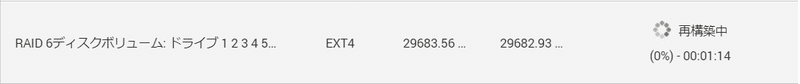

作ったらあとは同期を待つ。

一応、同期中でも利用は可能なのですが、

遅っ!!!

これはちょっと実用に耐えないレベルです。

素直に同期完了を待つことにします。

(実はここがフラグでした)

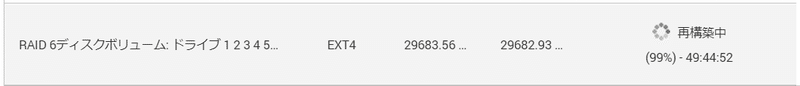

終わらない同期・息切れ・眩暈

ううん…

同期が全く終わりません!

RAID6 の同期は遅いとよく聞くけど、これはさすがに遅すぎる。

まぁ、ある程度予測はしてたけど、SMR なディスクじゃ RAID6 はダメですかねぇ。

で、途中で一度電源を落とす必要に迫られたので、シャットダウンして再起動したら

最初からになりましたー

はい、てっしゅー

そんなわけで、SMR でやるのはお勧めしません。

てゆーか無理。

CMR ディスクを確保する

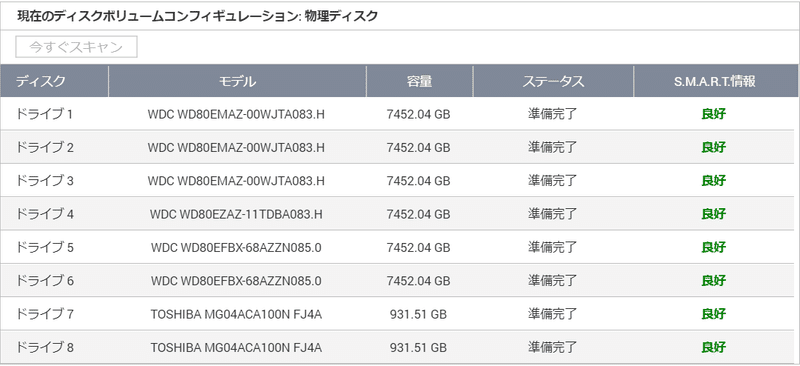

一応、手元には WD Red 系列の 8TB も(型番バラバラだけど)8台あることはあります。

ただ、それらにはデータが入っているので退避しないとなりません。

これにものごっつい時間がかかりました。

なんせ 8TB × 8 の大移動です。

取り出した WD Blue 6TB や、余っているディスクを使って移動するわけですが、一度に接続できる数に限りもあり、Windows で同時に大量の転送をすると不安定になることもあり、これに1週間くらいかかりました…

で、結果、なんとか

WD80EMAZ × 3

WD80EZAZ x 1

WD80EFBX x 4

を確保。

EMAZ と EZAZ はヘリウム充填モデルですね。

Ultrastar He10-8 ベースで低速化されたタイプで、型番は違うけど中身はほぼ一緒です。EFBX は以前空冷化した空気充填のアチアチモデルです。

RAID は同型番で組むのが鉄則とされていますが、まぁなんとかなるでしょう(こればっか)

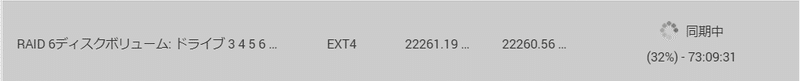

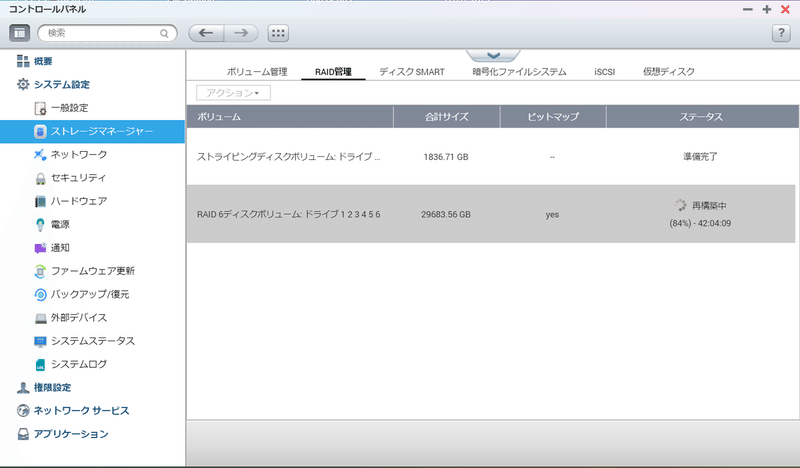

再挑戦

東芝の 2TB は TS-473 に持って行ったのでベイの順番が変わりました。

作ります。

まぁ、当然こちらも同期中でも使えます。

ベンチマークかけたら、同期中でも普通の速度に!

そうだよなぁ、WD Blue の方はこの時点で諦めてやめるべきだったよなぁ。

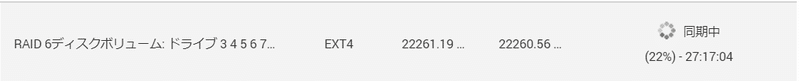

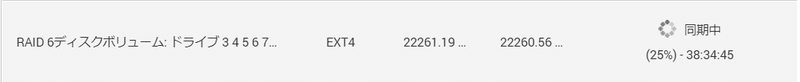

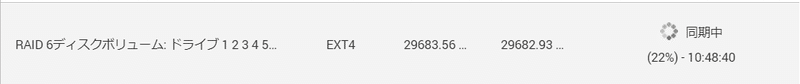

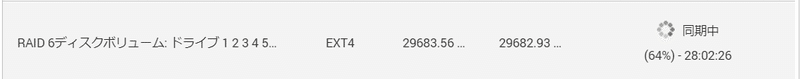

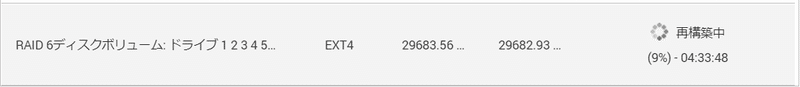

同期も今度は息切れすることなく順調に進み、気付くと完了してました!

安定して 10%/5時間 くらい。

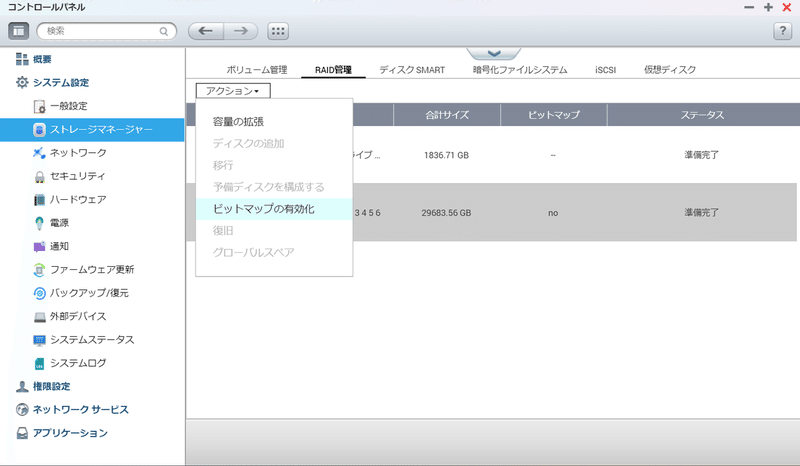

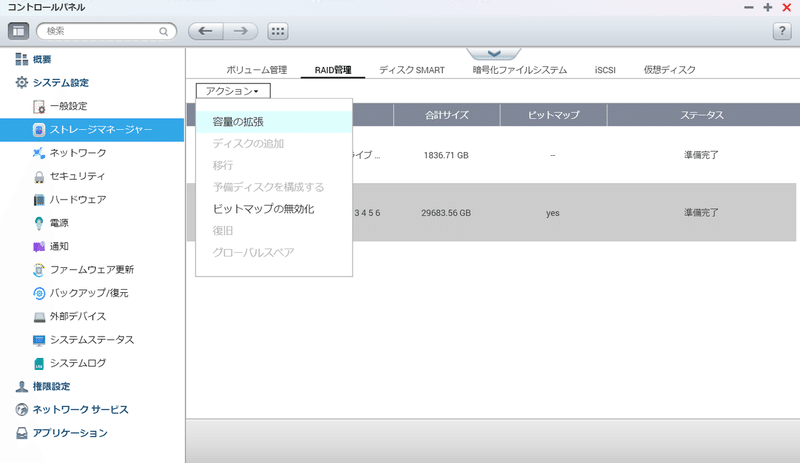

ビットマップを有効化しておきます。

これは「更新部分を記録しておいて、一部同期されたディスクを抜き差しした場合の再同期を高速化」するための機能です。

ぶっちゃけ、一部同期済のを再度入れるなんてシチュエーションは来ない気がしますが…

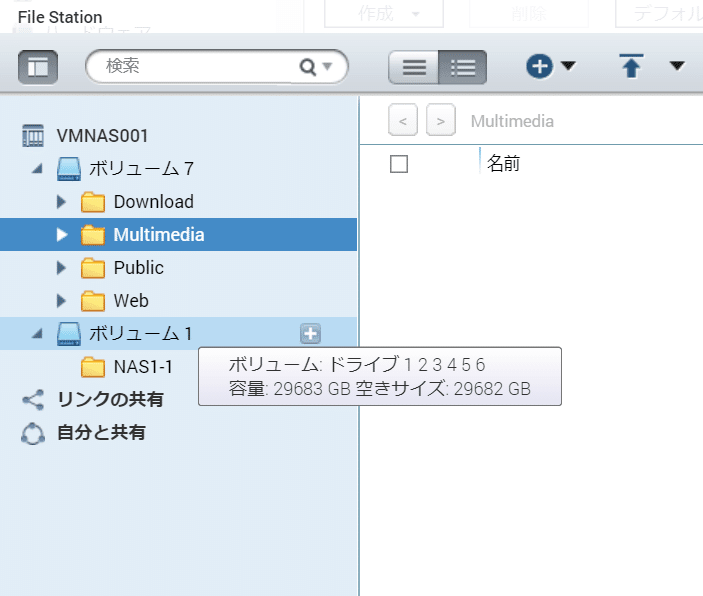

[/share/NAS1-1] # df .

Filesystem Size Used Available Use% Mounted on

/dev/md1 29.0T 128.0M 29.0T 0% /share/MD1_DATA6台で 29TB。

1TB = 0.909TiB 強のはずなので、0.909 x 8 x 4 = 29.088 で概ねあってる。

(あたりまえ)

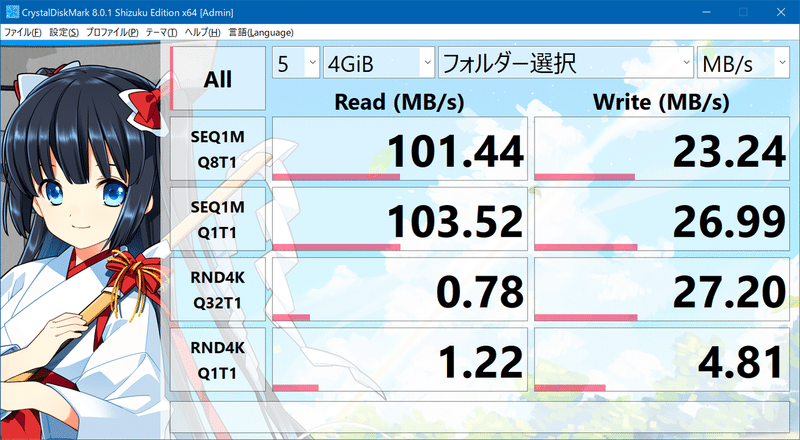

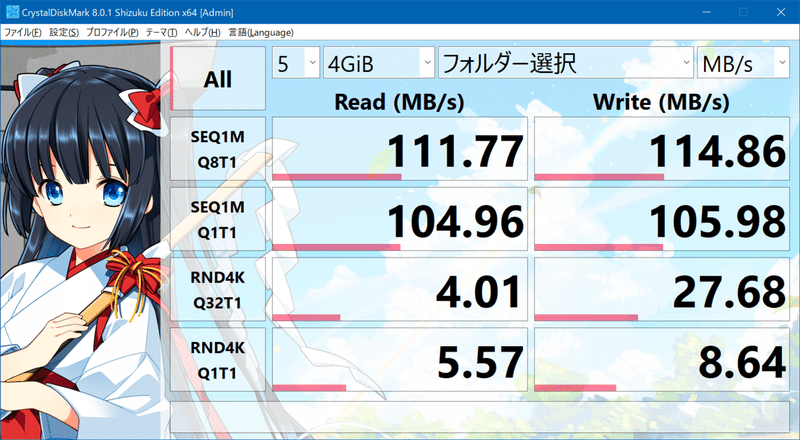

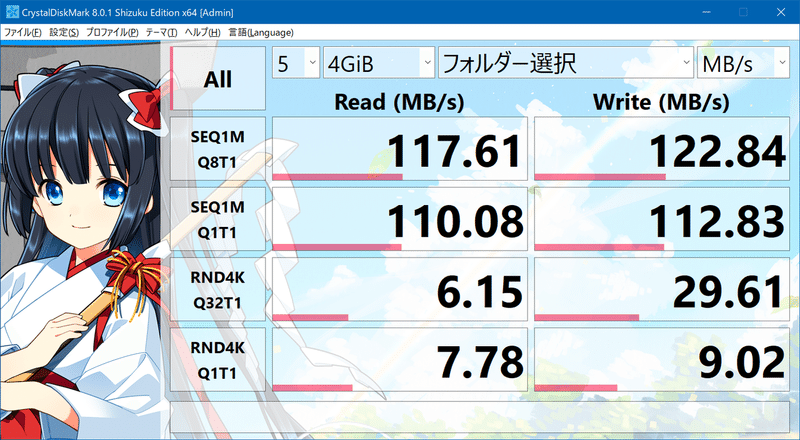

同期完了後のベンチマーク。

同期中より1割くらい速いかな。

CLI 上で軽く調べてみたところ、

[/share/NAS1-1] # hdparm -t /dev/md1

/dev/md1:

Timing buffered disk reads: 824 MB in 3.00 seconds = 274.54 MB/sec

[/share/NAS1-1] # time dd if=/dev/zero of=/share/NAS1-1/write.tmp bs=4k count=1000000

1000000+0 records in

1000000+0 records out

real 0m35.856s

user 0m1.282s

sys 0m33.395s

[/share/NAS1-1] # time dd if=/dev/zero of=/share/NAS1-1/write.tmp bs=1M count=4000

4000+0 records in

4000+0 records out

real 0m26.344s

user 0m0.044s

sys 0m21.012sGB か GiB かの問題がある(ので、混在してみた)けど

Read 270MB/s

Write 130MB/s

くらい?

ソフトウェア RAID だし、CPU 貧弱だから仕方ないかな。。。

そう考えると、GbE でちょうどいいのかもしれない。

交換テストをする(1台)

ディスク故障での交換を模したテストを行います。

RAID6 で、2台までは故障 OK なので1台のテストと2台のテスト、さらに3台目が壊れた風になった場合にどうなるのか。

いきなりぶちっと抜いてもいいのですが、お行儀よくいきましょう。

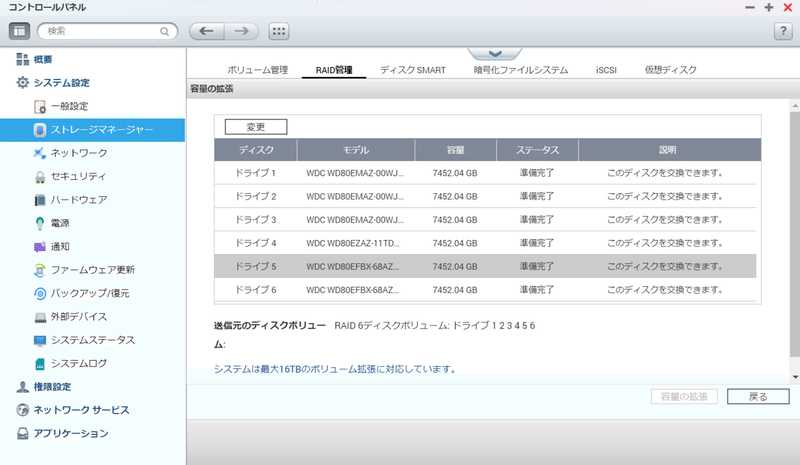

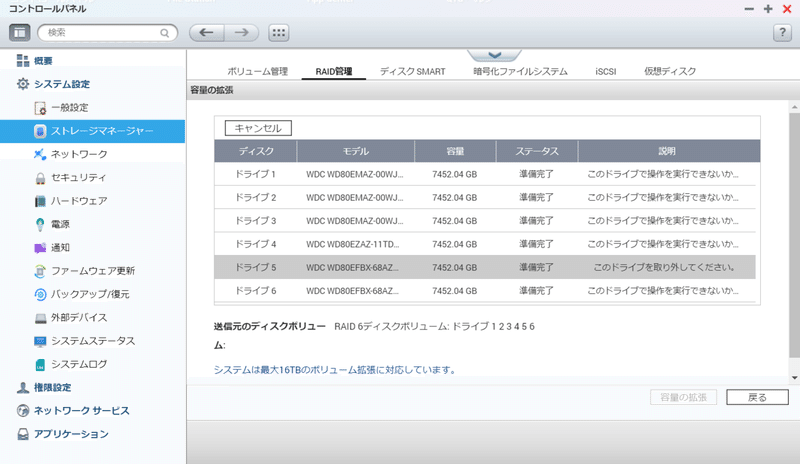

RAID管理のアクションから「容量の拡張」を選びます。

拡張するのでない場合でも「容量の拡張」です。ややこしいですね。

抜くドライブを選択して「変更」を押すと取り外し可能モードになります。

…あれ?

1台を変更にすると、2台目を変更できなくないですか?

故障時以外の2台同時抜きはできないのかなぁ…?

ということで、2台同時のテストはスキップ。

気を取り直して。

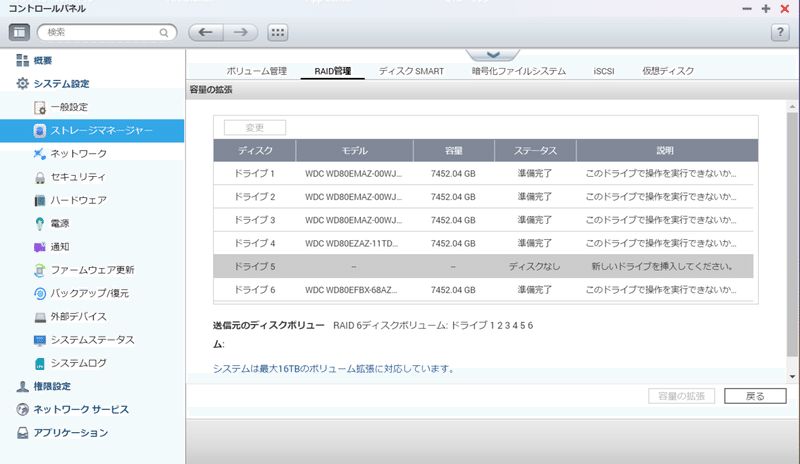

抜くと消えます(あたりまえ)。

そしてやはり、2台目の操作はできません。残念。

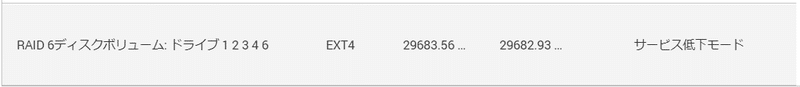

1台外れている状態だとサービス低下(デグレード)モードになります。

この状態だと速度が落ちたりする RAID もあるんだけど、QNAP はあんまり関係なさそう。

せっかくなので、抜いた状態でファイルを1つ作って、そのまま挿し戻したら即復旧しました。

ビットマップの効果。

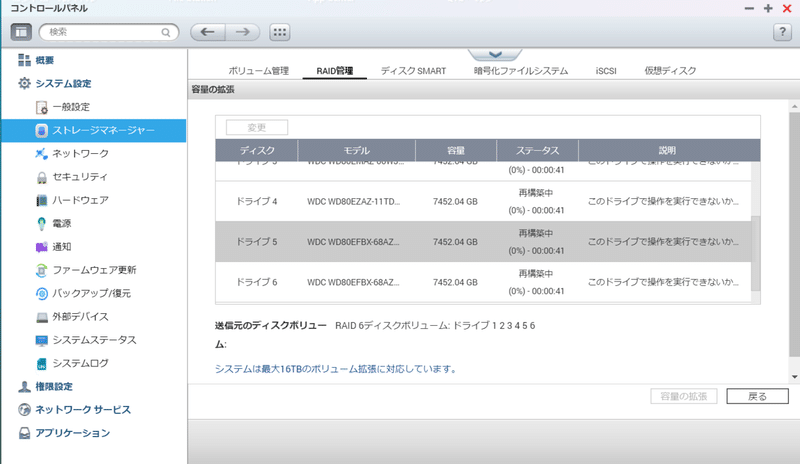

で、ディスク交換を模すので、一旦抜いたものを別 PC でフォーマットして、真っ新なディスクのつもりで挿入します。

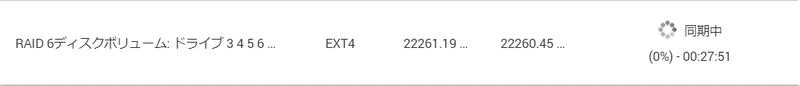

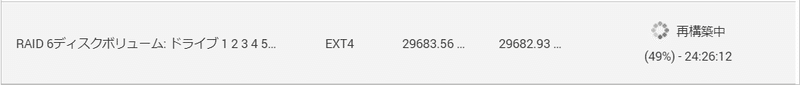

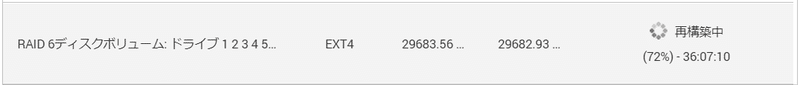

少しすると認識して即再構築が始まります。

そのベイを RAID から除外して個別ディスクとして使う、というわけにはいかないっぽい?

普通の同期と同じで、10%/5時間 くらいの進行度でした。

ちなみに、RAID 再構築中は「アクション」メニューが使えません。

再構築中にディスクエラーが発生した時とかはどうするんだろう??

交換テストをする(2台/3台)

というわけで、2台や3台の交換テストはできないのでした。

HERE COMES A NEW CHALLENGER!

などとテストなどをやっている間に、追加で WD80EZAZ x3 を入手したため、構成を

WD80EMAZ × 3

WD80EZAZ x 4

WD80EFBX x 1

にします。(もう1台 EMAZ か EZAZ 欲しいな)

1台ずつ差し替えです。そのたびに 2-3日待ちです。

2台同時差し替えしたいよ。

さすがに他のドライブの空きが無くなってきてしまったのでテストをしながら運用開始してしまうことにします。

ドライブを増やしての容量拡張はまた後日。

本当は、容量拡張失敗してデータ消える可能性があるからテストしてからやりたかったんだけど、ぶっつけ本番になりますね。

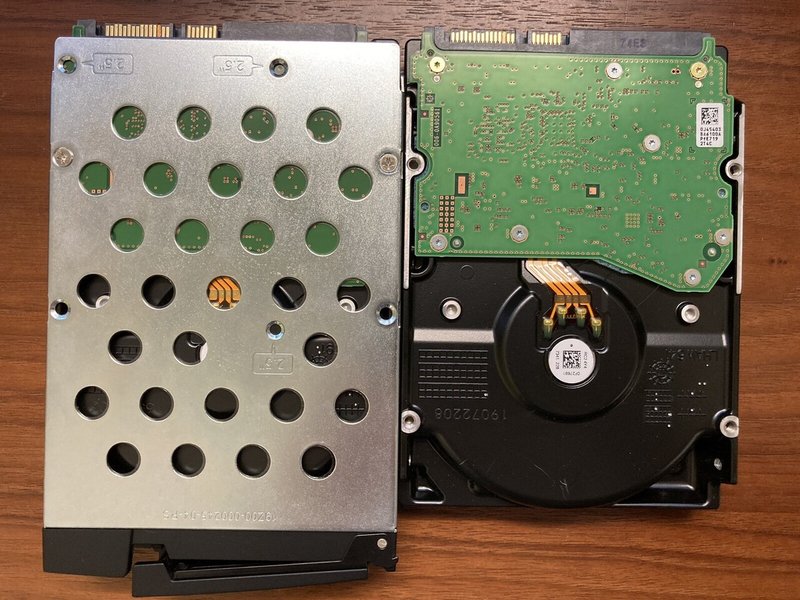

ちなみに

EZAZ さん、底面4つ穴なのでネジが半分締まりません!

HDD によっては横面のネジ穴も中央がなくなっていたりするらしいです。

これネジだからいいけど、突起などの場合は折るか諦めるかしないといけないので、最近の HDD を古いケースに入れる場合は要注意です。

あとなぜか追加した2台の EZAZ、同一の製造時期、同一の R/N なのに、ケースの形状が違います。

こんなことあるのね。

この記事が気に入ったらサポートをしてみませんか?