【論文瞬読】RAGシステムにおける意外な発見:無関係なドキュメントが性能向上の鍵だった!?

こんにちは!株式会社AI Nestです。今日は、自然言語処理の分野で注目を集めているRetrieval-Augmented Generation (RAG) システムについて、とてもエキサイティングな研究論文を紹介したいと思います。

この論文では、RAGシステムの情報検索 (IR) コンポーネントの役割に着目し、検索されるドキュメントの種類が及ぼす影響を詳細に分析しています。その結果、従来のIRシステムの常識を覆すような、驚くべき知見が得られているんです。

タイトル:The Power of Noise: Redefining Retrieval for RAG Systems

URL:https://arxiv.org/abs/2401.14887

所属:Sapienza University of Rome Rome, Italy, Technology Innovation Institute Haifa, Israel, University of Pisa Pisa, Italy

著者:Florin Cuconasu, Giovanni Trappolini, Federico Siciliano, Simone Filice, Cesare Campagnano, Yoelle Maarek, Nicola Tonellotto, Fabrizio Silvestri

RAGシステムとは?

まず、RAGシステムについて簡単に説明しましょう。RAGシステムは、大規模言語モデル (Large Language Models: LLMs) の生成能力を拡張するために開発された技術です。LLMsは強力な言語生成能力を持っていますが、その知識は事前学習時のデータに限定されるという制約があります。

RAGシステムは、この制約を克服するために、外部データを動的に取り込むことで、LLMsの文脈理解力を向上させようとするものです。具体的には、IRコンポーネントを用いてクエリに関連するドキュメントを検索し、その情報をLLMに提供することで、より適切な応答を生成できるようにするのです。

従来のIRシステムとの違い

従来のIRシステムでは、クエリに対して関連性の高いドキュメントを検索することが重要視されてきました。つまり、クエリの内容に直接答えられるような、金の延べ棒のようなドキュメントを見つけることが理想とされてきたわけです。

ところが、この研究では、RAGシステムにおいては必ずしもそうではないことが明らかになりました。むしろ、関連性のあるドキュメントよりも、無関係なドキュメントを含めることでパフォーマンスが向上するという、一見直感に反する結果が示されたのです。

実験と結果

研究チームは、Natural Questions (NQ) データセットを用いて、ドキュメントを関連性に応じて4つのカテゴリ(gold, relevant, related, irrelevant)に分類し、それぞれがRAGの性能に与える影響を評価しました。

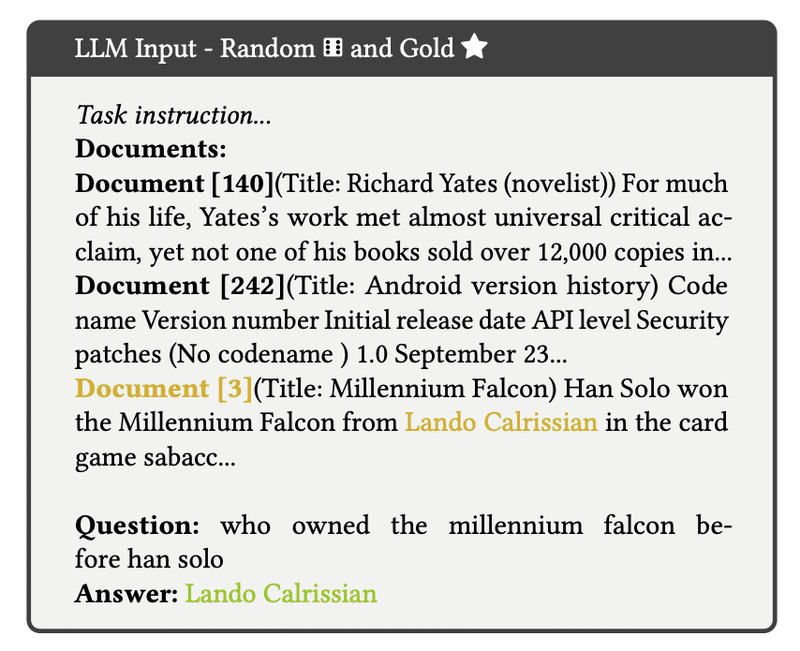

まず、goldドキュメントのみをLLMに入力した場合の例を見てみましょう。図1は、LLMへの入力例とLLMの誤った出力を示しています。

次に、relatedドキュメントとgoldドキュメントをLLMに入力した場合の例を見てみましょう。図2は、LLMへの入力例とLLMの誤った出力を示しています。

図3は、図2の例における、生成された回答の各トークンに対するコンテキストドキュメントへのアテンション分布のヒートマップを示しています。これにより、relatedドキュメントがLLMの出力に大きな影響を与えていることがわかります。

表1は、relatedドキュメントの数を変化させたときのLLMの精度結果を示しています。relatedドキュメントを追加すると、RAGの性能が大幅に低下することがわかります。

一方で、irrelevantドキュメントを含めると、驚くべきことに最大で35%もの精度向上が見られました。図4は、irrelevantドキュメントとgoldドキュメントをLLMに入力した場合の例とLLMの正しい出力を示しています。

表2は、irrelevantドキュメントの数を変化させたときのLLMの精度結果を示しています。irrelevantドキュメントを追加することで、RAGの性能が向上することがわかります。

この現象は、複数の言語モデル(Llama2, Falcon, Phi-2, MPT)を用いた実験でも一貫して観察されており、結果の信頼性は高いと言えます。

なぜirrelevantドキュメントが効果的なのか?

では、なぜirrelevantドキュメントがRAGの性能向上に寄与するのでしょうか?この点については、研究チームも明確な結論を出せていませんが、言語モデルのアテンション・エントロピーに関連している可能性が示唆されています。

つまり、irrelevantドキュメントを含めることで、言語モデルのアテンションが分散され、より多様な情報を考慮できるようになるのではないか、というわけです。ただし、この仮説については、今後さらなる研究が必要とされています。

RAGシステムの検索戦略

この研究結果は、RAGシステムにおける検索戦略の再考を促すものです。従来のIRシステムの設計思想とは大きく異なり、関連性の高いドキュメントのみを追求するのではなく、適度にirrelevantドキュメントを含めることが重要だということがわかりました。

表3は、実際のRAGシステムにおける、検索されたドキュメントとランダムなWikipediaドキュメントを組み合わせたときのLlama2-7bの精度結果を示しています。

さらに、表4は、検索されたドキュメントとRedditから取得したirrelevantドキュメント、およびランダムな単語で構成された無意味な文を組み合わせたときのLlama2-7bの精度結果を示しています。

また、表5は、検索されたドキュメントとirrelevantドキュメントを組み合わせたときのFalcon-7bの精度結果(Redditデータを使用)を示しています。

これらの結果から、3〜5個程度のrelevantドキュメントを検索し、残りをirrelevantドキュメントで埋めるのが最適だと考えられます。

まとめ

今回紹介した論文は、RAGシステムにおけるIRの役割について新たな視点を提供し、従来のIRシステムの設計思想に一石を投じる内容でした。irrelevantドキュメントが重要な役割を果たすという発見は、直感に反するものですが、実験結果は明確にその効果を示しています。

この研究は、RAG研究の新たな方向性を示唆するものであり、IR分野全体にとっても示唆に富む内容だと言えるでしょう。今後、この知見を活かした新たなRAGシステムの開発が期待されます。

同時に、irrelevantドキュメントがRAGの性能向上に寄与するメカニズムの解明は、今後の重要な研究課題の一つだと思います。言語モデルの内部動作に関する理解を深めることで、よりインテリジェントなRAGシステムの実現につながるかもしれません。

皆さんも、この論文を一読して、RAGシステムの可能性について考えてみてはいかがでしょうか。それでは、今日はこの辺で失礼します。