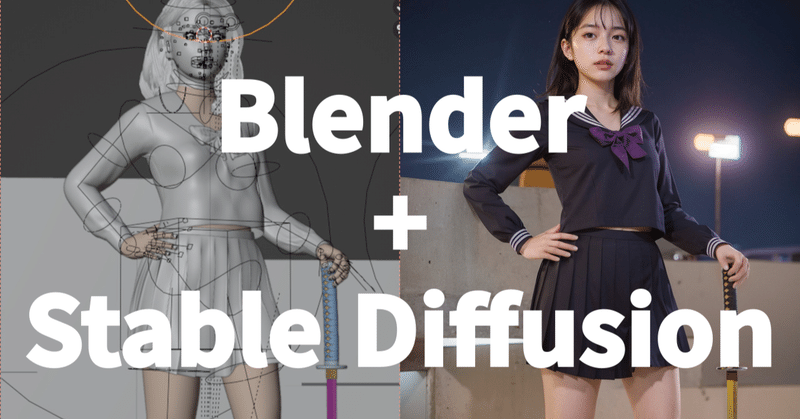

【中級者】Blender+Stable Diffusion

想定する読者

Blender を利用した事のある人

Stable Diffusion webUI を利用した事のある人

ControlNet を利用した事のある人

Gimp や Photoshop などの画像処理ソフトウェアの基本機能を利用した事のある人

はじめに

Blender で生成AIを利用すると聞くと、アドオンを利用してテクスチャを生成したり、3Dモデルを生成したりするのかと思ってしまうかもしれませんが、ここではもっと原始的な方法を紹介します。結論を言うと、Stable Diffusion の i2i(image to image)機能を利用するだけです。

昨今の生成AIの最大の問題は「クオリティ」です。確かに、手軽にリアルな画像を生成できるようになりましたが、指や構造物の背景コンテキストをはじめ、細部はめちゃくちゃになります。現実ではないアニメ系の画像や、解像度の低い動画であればそれほど気になりませんが、静止画であれば、物理的におかしな箇所に対して心霊写真並みにムズムズしてしまうのです。指や足の数が合わないのですから。

これらの「不自然さ」は、今のAIフレームワークでは解決が難しく、さらなるブレークスルーが無い限り解決されない見通しです。そこで、これらを解決させる方法として、AIが不得意とする箇所を人間が作った3Dで補ってやるという手法を利用します。

実際に、リアルな動画生成で話題になった OpenAI の Sora 等も似たような手法を利用しています。膨大な2D画像を学習し推論する拡散法だけでは解決できない問題を、物理シュミレーションの情報を利用して解決しようという試みです。物理的正しさの情報をAIネットワークに追加したわけです。つまり、3Dモデルを利用するという事は、Sora AI の物理シミュレーション部を人間がやってるという話になるのかもしれません。

準備

用意するもの

【Blender】

公式サイトよりダウンロード&インストールしてください。 https://www.blender.org/

人物系3Dモデルの基本的な使い方のBlender入門書を無料で配布しています。https://catapp-art3d.booth.pm/items/4350898

【3Dモデル】

ここでは筆者が BOOTH で公開・販売している人物モデルを利用します https://catapp-art3d.booth.pm/items/4165455

【Stable Diffusion webUI + ControlNet】

https://github.com/AUTOMATIC1111/stable-diffusion-webui

はじめてAI生成画像ソフトウェアを利用する人には導入の敷居が高いかもしれませんが、webUI 本体と機能拡張 ControlNet (depth) を利用します。

最近は、Stability Matrix 等のボタンひとつでインストールできるローカル生成AI界のデ・ファクト・スタンダードツールが登場しはじめています。ただし、筆者は信頼性の低いオートツールは極力避けるようにしていますので利用はしていません。バグがあった場合に管理できませんので。

BOOTHでもバージョンは低いですが、導入のための入門書も販売しています。

Blenderで構図の作成

ここから先は

この記事が気に入ったらサポートをしてみませんか?