iPhoneの自動画像スキャンによって監視社会が始まった😭

どうも、ドラカスです。

今日も今日とてJKモノのエロ漫画を読み漁っていたところ、とんでもないニュースを目にしました。

このニュースでAppleが発表した事項は2つあります。

1.「iPhoneに保存された写真を検査して、児童ポルノ画像を発見できるようにする」という内容。

2.「13歳未満のユーザがiMessage上で送受信した画像を検査してエロ画像を発見し、なおかつ親のiPhoneに通知する」

というものですね。

僕はこのニュースを見て、二度とiPhoneを使わないと心に誓いました。別に僕が児童ポルノ画像を持っているとか、そんなわけではありませんよ。

はじめに

そもそもの話として、現段階でこれらの機能は米国でのみ提供されるとのことです。なので、日本で導入される段階では、内容に差異があるかもしれませんし、導入すらされないかもしれません。

さて、上記の記事にも書かれてはいるのですが、改めて本件の内容を深堀りしていきましょう。

1.「iPhoneに保存された写真を検査して、児童ポルノ画像を発見できるようにする」

厳密に言うと、ここでも更に2つのパターンがあります。

iCloudにアップロードされている写真のスキャンと、iPhoneの端末に保存されている写真のスキャンです。

どっちも似たようなものなので便宜上一つの項目として扱います。

前提として、この機能を追加する目的は「児童ポルノ対策」のためです。子供を守る素晴らしい志だと思います。

では、どうやって画像を検査するのでしょうか?

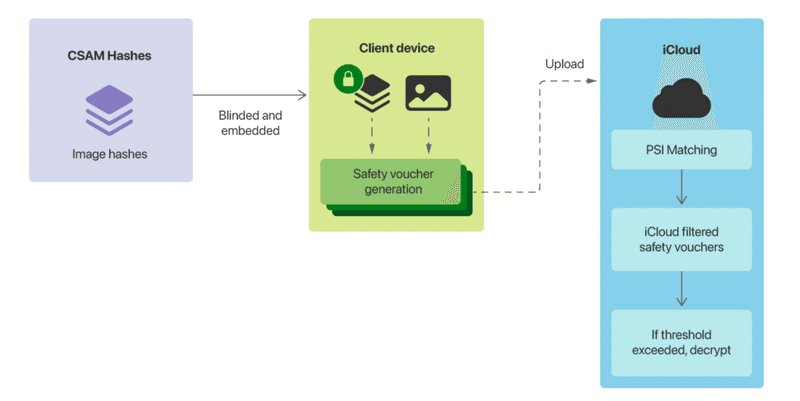

まず、米国には「全米行方不明・被搾取児童センター(NCMEC)」という機関が存在しており、当機関はこれまで通報された児童ポルノ画像などの資料(CSAM)のデータベースを保持しています。

AppleはそのデータベースをiPhoneに搭載し、保存された画像とデータベースを照らし合わせて、児童ポルノ画像を発見するというわけです。

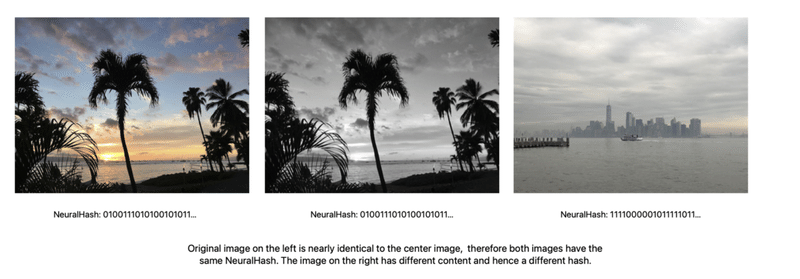

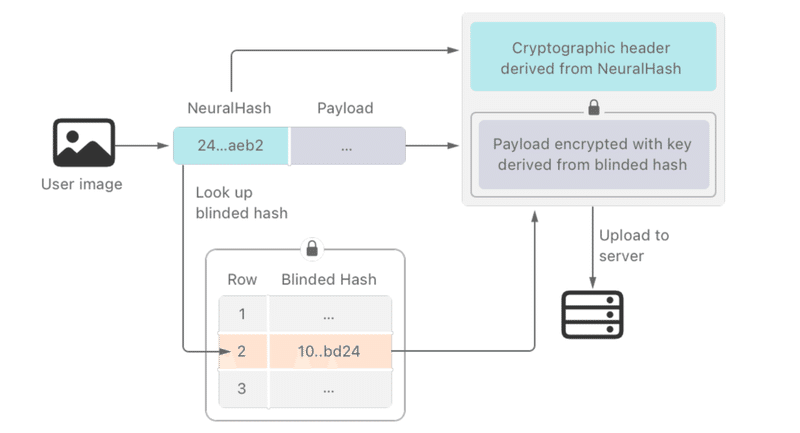

画像を照らし合わせると言っても、実際に写真のような形式で比較しているわけではなく、機械学習を用いて大量の児童ポルノ画像から作り出したハッシュ値と比較を行っています。

(引用元:Expanded Protections for Children — Technology Summary/https://www.apple.com/child-safety/pdf/CSAM_Detection_Technical_Summary.pdf)

検査の結果、データベースの内容と極めて類似性の高い写真にはフラグが付与され、Appleへ送信されます。その後、Appleで審査を行い、最終的にNCMECへ通報するか、破棄するかの処理を行うんですね。

実はずっと以前から、上記のような処理を実装している前例はあります。Google Photoに関しても似たような検査を行っていますし、MicrosoftのPhoto DNAも同様です。ただ、留意すべきなのは、今例に挙げたものは全てクラウドストレージでの話であって、ローカルでの処理ではありません。

また、一連の処理は全て、ユーザが認知できない部分で、勝手に行われます。

【問題点】

①プライバシーの問題

現在のiPhone(iOS)はデフォルトで暗号化APFSボリュームとなっており、パスワードを設定した時点で自動的に端末内のデータは暗号化されています。そして、復号のためのキーはAppleでも取り出すことは不可能です。(「やろうと思えば手段を用意することは可能だがやらない」とFBIからのロック解除要請を跳ね除けた時に発言していました)

つまり、iPhoneの端末内に保存されているデータの所有権は絶対的にユーザにあるわけです。

ところが、今回の機能が追加されることで、画像データは許可もなく変換され、許可もなくデータベースと比較された後、場合によっては許可もなくAppleへ送信されます。

これでは、本当にデータの所有権がユーザにあるとは言えません。

②誤検知の問題

送信された画像が児童ポルノであれば致し方のないことですが、実際は機械学習も万能ではないので、「限りなく黒に近い」ということまでしか判定はできません。最終的には人間によって判断しなければ、確実ではないのです。となると、誤って検知された画像がAppleに送信される場合も充分にあり得るわけです。

Appleは「誤って検知される可能性は極めて低い」と謳っていますが、同時に「誤って検知された場合は異議申し立てが行える」とも述べています。まぁ、誤検知はAppleも想定内ということです。

個人的な意見としては、誤検知が起こる可能性は割と高いと思っています。例えば、Twitterを利用されている方で、「普通の健全な画像なのに、なぜかセンシティブなコンテンツにされてるぞ?」といったケースを目撃した経験はありませんか。他のSNSにおいてもそうですが、基本的に現代の機械学習でエッチなコンテンツを識別できる精度はあまり高くありません。

翻って、今度は別のケースを考えます。Google Photoで”自分の娘”と入浴中に撮影した写真が、児童ポルノと判定されたケースがありました。これは機械的にはエラーではありません。機械は子供の裸を判定するという処理を行っただけで、その子供が撮影者とどういった関係なのか、その撮影はどういうシチュエーションなのかは考慮しませんからね。つまり、画像を機械的に判定する場合においては、機械的な誤検知と、論理的な誤検知の双方を考慮しなければならず、どちらも現実的に考ると現時点で誤検知を限りなく少なくするのは難しいというわけです。

そして、先程も述べたとおり、NCMECの作成したデータベースの内容と、処理の内容、処理の結果はユーザが認知することができません。それらを踏まえて考えると、恐らく相当数の画像が知らぬうちにAppleへ送信され審査が行われるのは目に見えています。

③Appleの定めた基準に依存してしまう

現実問題として、日本在住で児童ポルノに興味があり、実際に所有している方はあまり多くないと思います。なので、今回の機能についても、自分とは関連がないと考えてる方が大多数なのではないでしょうか。

しかし、例えば規制の範囲がイラストにまで及んだらどうでしょうか。Twitterは「児童の性的搾取に関するポリシー」において、当該ポリシーの基準にイラストも含めています。FGOというスマホゲームで、露出度の高い美少女のイラストが米国で規制されたり、同じくスマホゲームのアズールレーンが中国でイラストの規制をされるといった話もありますね。もしそれが、iPhoneに保存されている画像にも適応されたらと考えると、恐怖で金玉が縮みます。

これらの決定権は全てAppleにあり、法的に違反していない画像であっても、Appleが独自の基準を定めれば、検知して採取することは可能です。

④保護すべきデータの範囲が不明確

果たして保護すべきデータの範囲はどこなのでしょうか?

例えば、今回はiPhoneの場合、写真アプリ内のデータ、つまりiPhoneのフォトライブラリに保存されたものが対象です。では、その他のディレクトリに保存されている写真はどうなのか? 外部アプリのデータは? 果てにMacまで対象となったら、本体ストレージ内の全てが検査対象なのか? 外部メディアの中身は? 接続中のネットワークドライブの中身は? 暗号化コンテナを復号し、マウントしたらその中身も?

といった感じで、どこまでのデータにプライバシーが担保されているのかがわかりません。

そもそもなぜ画像は勝手に検査していいという考えなのかもわかりません。

なにもわからないよ……

2.「13歳未満のユーザがiMessage上で送受信した画像を検査してエロ画像を発見し、なおかつ親のiPhoneに通知する」

これも非常に気持ち悪いですが、まぁ僕は13歳未満ではないし、iMessageなんて使わないので関係のないことです。

……とも言ってられません。

当該項目についても、前項と同様の問題点を孕んでいるのは事実です。むしろ、単純な検査項目としてはこちらのほうがよっぽど恐ろしい。

さて、まず認識するべきことは、前項の機能は「児童ポルノ対策」を目的として導入されたもので、検査されるのもそれに準じた画像が対象でしたが、本項は全てのエロ画像が対象となっている点です。

つまり、既にAppleは技術的にiMessageで送受信された画像を検問し、それがエロ画像かを検査する機能を開発しているということになります。そして、その機能は単純にユーザの年齢によってアンロックするかどうか決めているだけですから、iMessageそのものにプライバシーは無いも同然です。なのでいくら皆さんが大人でも、送信相手のユーザが未成年(後述)であれば、こちらから送る画像が全て監視対象となるわけです。

更に、もし13歳未満のユーザがおっぱいなどのエロ画像を受信した場合、それがシステムに検知されると、親に通知が送られます。通知には「お前の子供がおっぱいの画像を保存しようとしてるぞ」という旨のメッセージと、実際に受け取った胸の写真が表示されます。ちなみにおっぱいの写真はユーザ本人は削除することができず、親が削除の権限を持ちます。まぁ、絶対に親に見られるってことですわな。僕は小学校4年生くらいからエロ画像をみていたので、この機能があったら生きて行けませんね。

また、13歳未満で無くとも、17歳以下のユーザであれば、同様の検査が行われることとなっています。ただし、親への通知は行きません。

【問題点】

①iMessageがE2EE対応とは呼べなくなった

E2EEとはエンドツーエンド暗号化の略で、要は「全てのメッセージは暗号化され、送信者と受信者の二者しか内容を読めない」とするシステムのことです。当然、サービス提供者(本記事でいうとApple)もユーザのメッセージを読むことはできません。

例えば日本人に馴染みのあるLINEにおいては、テキストデータのみE2EEに対応しています。画像や動画に関しては通信する上での暗号化は行われますが、データそのものの暗号化は行われません。だから韓国に飛ばされます。

完全なE2EE対応のメッセンジャーで有名なものは、SignalやTelegramです。どちらも犯罪者に悪用されているので怪訝な目で見られがちですが、裏を返せばセキュリティがしっかりと施されているというわけです。

さて、話を戻すと、iMessageも”これまでは”E2EEが有効となっており、Appleの掲げるプライバシー保護の内容に相応しいメッセンジャーでした。ところが今回、未成年ユーザに検問が入ってしまいます。画像を比較する以上、システムは対象となる画像そのものを確認しなければなりませんから、端末上で既に復号し終えた画像に対して検査を行うはずです。確かに、サーバではなく端末上で実行される処理なので、その時点までは送信者と受信者のみがアクセスできるE2EEの仕組みとして、間違ったことはしていません。しかし、問題はその後、Appleのブラックボックスな検査によってラベリングされた画像が勝手にどこかへ送信されるなど、明らかにシステムとしては越権であると言える処理を行うことです。また、本来E2EEのシステムであれば、基本的なメッセンジャー機能の他に提供すべきは「データの暗号・復号化の機能」のみであるべきです。システムが勝手に復号化したデータを再利用していいわけがありません。

総合的な問題点

①他のシステムに導入される可能性がある

もしAppleが本機能を実現させた場合、GAFAの内の一社が端末内のデータを勝手にパターン化・ハッシュ化して比較する行為を是とした前例ができるわけですから、他の企業も同様の機能を導入する可能性が高いです。

②そのシステムが善意のある組織に運用されるとは限らない

散々述べていますが、これらの機能において、検知されるコンテンツの内容や閾値は、実装する側の独断で決定することができます。Appleが悪魔かどうかは別としても、例えば実装する側がLGBT反対派であったり、その他何らかの思想を掲げていれば、それに反するデータは同様の機能を用いて規制することが可能になるというわけです。

③iCloud写真をオフにすれば良いという問題ではない

この記事によると、iCloud写真機能を無効化することで、今回の画像スキャンが動作しなくなると記されています。

個人的には、これはあまり正確な表現だと思いません。

今までかなり簡略化して機能を説明していましたが、もう少し詳しく見てみましょう。

参考文献となるPDF資料は以下のページにあります。

CSAM Detectionに書かれている内容と先程の記事を見るに、iCloud写真を無効にしたことによる影響はThreshold Secret SharingとOn-Device Voucher Generationの2つが機能しなくなる点です。

つまり、iCloud写真を無効にしても、端末上で保存されている写真のNeuralHashの生成とバウチャーの生成は行われます。ただし、それらがAppleのサーバへ送信されることはないので、Blinded Hashの値を得られず、閾値の算出(というか復号そのもの)が不可能となります。

そのため、正しくは、iCloudないしAppleのサーバへ写真が送信されなくなるだけで、画像スキャン自体は行われるということです。また、Appleは端末からバウチャーさえ取得してしまえば、そのコンテンツと比較対象のコンテンツとの類似性を知ることができます。しかし、On-Device Voucher Generationはサーバのみに存在するハッシュを用いるため、ユーザは自分の画像に対して検査が行われたことを知る余地がありません。というわけで、機能を完全にOFFにする選択肢を与えない限り、iCloud写真を無効にしても本質的な問題は解決されません。

余談.Siriと検索機能

SiriやiPhone標準の検索機能を用いて、児童ポルノ関連のキーワードを検索しようとすると規制されるようです。これもう金盾だろ。

Githubで署名活動やってます

海外でプライバシーの侵害だと声を挙げている方たちが、賛同者を募集しています。Githubアカウントを持っていて、Appleの新機能に反対の人はどうぞ。2021年8月8日の時点で5000弱ほどの署名が集まっています。

詳細

Githubページはこちら

おわりに

iPhoneを使わないのはいいのですが、別にGoogleも信用できないのでもうスマホ持てないですね。Blackberry、帰ってきてくれ。

この記事が気に入ったらサポートをしてみませんか?