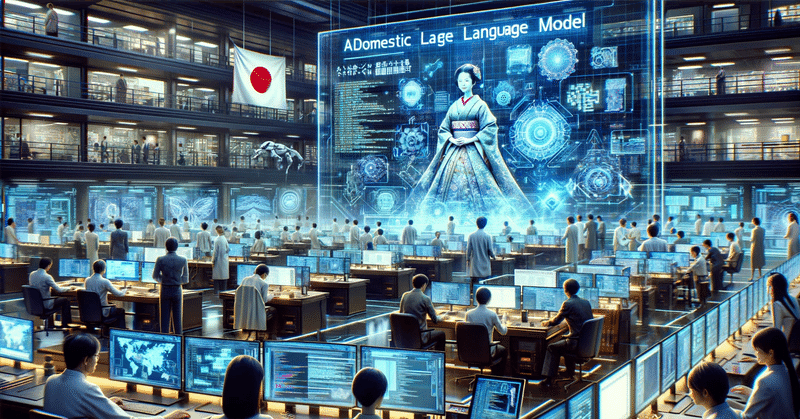

LLM(大規模言語モデル)とクラウドの国産化について

日本でのAIサービスやクラウド環境については、21世紀以降はほぼGAFAM(そろそろ死語でしょうか?)をはじめとした米国系企業で占められてきました。

ただ、産業面と安全保障面で鑑みると、リスクがなきにしもあらずです。

例えば、言語系生成AIはやはりユーザ層が多い英語のほうが優位なので、日本語の質が想定的に低下します。

そのため、ChatGPTプロンプトに慣れている人のなかには、あえて英語で考えさせるという人もいますね。(私も初めはそうしてましたが、最近は日本語でも質が高くなってる感覚)

安全保障面では、本社とデータセンターの物理的な所在が法的な影響を受けてしまうので、有事での継続性や透明性が気になるところです。

そんなリスクをはらむインフラ層ですが、この数週間日本勢の活動をよくニュースで目にします。

ようは、

自治体の個人情報を管理する政府クラウドに日本企業が選定された、

という話です。

まだ選定段階で条件付きですが、それだけでも日本企業の選定は史上初の出来事です。

しかもネット系企業というのが新しい時代が到来したことを感じさせます。(大体従来はIT総合メーカ勢)

そしてもう1つの生成AIの開発基盤ですが、比較的国家の視点で大がかりな取り組みがこちらです。

元々以前より日本語学習でのLLM(大規模言語モデル)は完成し、徐々にその性能が高まっています。

ちなみに、これを担うNICT(情報通信研究機構)は歴史が古い組織です。日本の無線系通信では少なからず影響を与えています。

2023年に注目しているニュースでは、理研等と組んで量子コンピュータのクラウドサービスを提供しています。

よくLLM性能を測る指標として使われるのが「パラメータ数」です。

NICTの最新版では、3000億超とのことです。

一見凄そうな数値ですが、今は世界トップレベルのLLMはインフレ状態です。

知る限りOpenAIはそのパラメータ数を公開してないと思いますが(逆に情報希望)、推測ではGPT3.5が2000億程度、GPT4だと数兆程度ともいわれています。

もちろんそれが性能の全てではなく、ChatGPT(3.5 or 4)よりもパラメータが多いLLMもいくつかあり、その差は後処理(ファインチューニング)にあるのでは?と考えられます。

ただ、日本語でのやりとり、においては期待できる水準になりそうな予感がします。

もちろん国家支援による研究だけでなく、民間企業でも大規模投資の話は出ており、目立つ企業を2つ挙げておきます。

LLMはすでに雨後の筍状態になりつつあり、この数年で淘汰されていく可能性が高いです。(資本が続かないと思います)

ただ、LLMだけに関して言えば、使われるほどそれだけ次の学習元にもあるため、英語圏が席巻し続けると言語格差が生まれるリスクもあります。

人類の知恵を引き出す魔法の箱も、いってしまえば過去の我々の出力した鏡のようなものです。

排他的になる必要はないですが、1つの選択肢としてぜひ国産系のLLM(もちろんクラウドも)には頑張ってほしいです。

この記事が気に入ったらサポートをしてみませんか?