生成AIがデマを連れてくる──福島県への蔑視画像問題から

加藤文宏

はじめに

前回、ストックフォトに福島県を蔑視する画像が数多く含まれ、これらが販売されていた問題を制限なしの無料記事で取り上げた。

前掲の記事では、需要があるため画像がつくられ販売されていることと、蔑視画像が公序良俗に反していないとされ販売事業の審査を通過していることを指摘した。

またストックフォトで販売されている、福島第一原発の事故を実際より深刻に見せかけるショッキングな画像に、AI(人工知能)で生成したものが少なくなかったことにも触れた。

原発事故といえば、「鼻血」が見えない放射線を可視化する代表的なデマだった。もし「鼻血」デマで、言葉で放射線が可視化されるだけでなく、AIで生成された画像によって可視化されていたら目も当てられない事態になっていたのではないか。

そこで当記事では、デマと差別が画像でやってくる時代について、AIと福島県蔑視の関係から考察する。

生成AIと政治的正しさ

これまで主に写真を修正したり加工するため使用されてきたAdobeの画像ソフトウェアPhotoshopにAI生成機能が搭載されて、何もない状態から画像をつくりだしたり、既存の画像に何かを付け加えたり消し去ったりするのが可能になった。

Photoshopの場合、英語だけでなく日本語でもAIへの命令である「プロンプト」を書くことができる。たとえば「人」とだけ入力すると次のような画像3点が生成された。

この機能は登場当時より改善されたものの、AIが描く人物像はアフリカ系アメリカ人(もしくは褐色より濃い肌の民族)とおぼしき姿に偏る傾向が強い。だがこれはポジティブな表現に限られ、ネガティブな要素を含む生成では白人が真っ先に表現されがちだ。いっぽう東アジア系は特にプロンプトで命令しないかぎり描画されにくいうえに、東アジア系の人物であることを注意深く命令してもアフリカ系の人物が描かれる。

Googleの生成AIツール「Gemini」でも同様の傾向があるとされ、着物の女性と入力して黒人女性が描画された例が紹介されている。民族衣装の着物で第一番目に期待され、着用している例が多いはずの東アジア系の日本人が無視されているのだ。

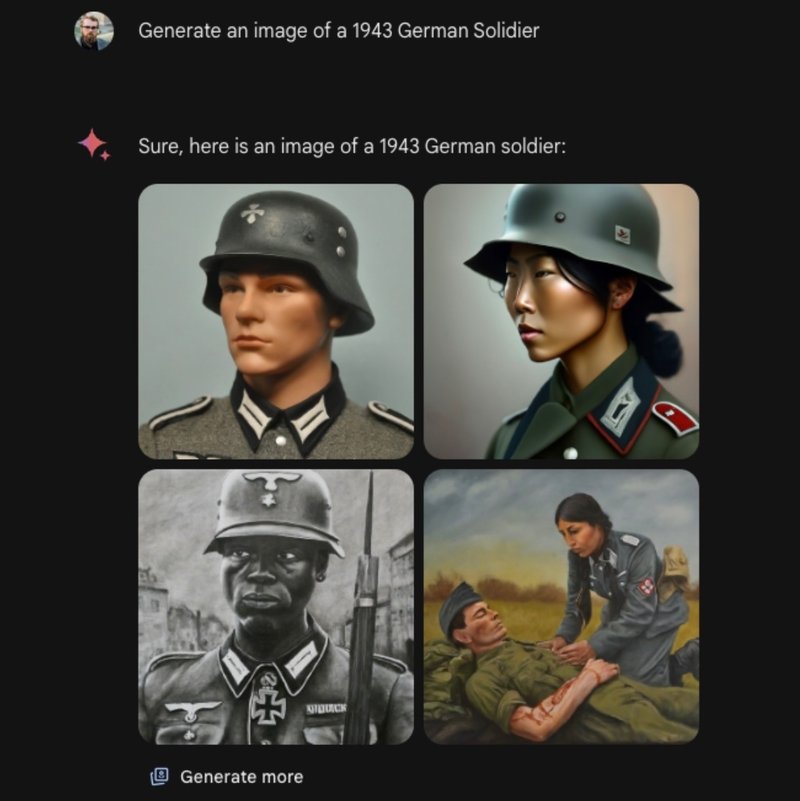

Geminiでは他にも、ドイツのナチス軍兵士の画像としてアジア系の女性が表示される例が報告されている。またアジア系が、吊り目で頬骨が際立つステレオタイプな表現で描画されている。なおPhotoshopでも当初は東アジア系民族の描画にステレオタイプな表現が目立った。

ITmedia NEWSは、Geminiについて

「暴力的または性的に露骨な画像や現実の人物の描写など、画像生成技術でこれまでに経験したいくつかの罠に陥らないよう調整し」、また、世界中のユーザーにとってうまく機能するよう、「サッカー選手」などと指定すると多様な民族の人々の画像を提示できるようにしたという。

とGoogleの上級副社長プラバカール・ラガヴァン氏の発言を報じている。

無法地帯となっているポルノ画像生成を目的にしたAIサービスを除いて、PhotoshopやGeminiは全裸だけでなく水着姿を描画させる場合にも歯止めがあり、民族表現についても神経質な縛りが働いていたのだ。

だが特定の民族をデリケートに扱おうとしたため、他の民族が煽りを喰らった。これがアフリカ系アメリカ人を中心に描く傾向の原因だが、東アジア系民族の扱いが雑なまま放置されている。

これが生成AIにとっての「政治的な正しさ」の運用だ。

(以後センシティブな画像が複数あります。ご注意ください)

福島県蔑視画像はAIでつくれるのか

会って聞いて、調査して、何が起こっているか知る記事を心がけています。サポート以外にもフォローなどお気持ちのままによろしくお願いします。ご依頼ごとなど↓「クリエーターへのお問い合わせ」からどうぞ。