JDLAの「生成AIの利用ガイドライン」が改訂、"何が変わったか"を解説してみた

ChatGPTなどの「生成AI」を企業・組織へ導入する にあたり、自社のガイドライン作成の参考としてしばしば活用されるのが、日本ディープラーニング協会(JDLA)の提供する「生成AIの利用ガイドライン」です。

MOTEXでも参考とする本ガイドラインが、2023年10月6日に改訂され、一部の内容に変更・追記がありました。

この記事では、生成AIを活用する企業・組織の皆さんに知っていただきたい、JDLAの「生成AIの利用ガイドライン」改訂のポイントについて読み解いていきます。

組織が「生成AIの利用ガイドライン」を理解すべき背景とは

今や、生成AIに関するニュースを見ない日は無いと言っても過言ではないほど、生成AIに関する期待は高まり続けています。

9月に開催したMOTEXのイベント『MOTEX DAYS.2023 -SUMMER- AI時代の到来とセキュリティ戦略』で登壇いただいた、シリコンバレーでベンチャーキャピタル(VC)に携わられている 前田さん(DNX Ventures Managing Partner 前田浩伸 氏)も、「日本ではお昼のワイドショーでも ChatGPT や 生成AI が頻繁に取り上げられているのを見て、アメリカより断然話題に上がる機会が多いことに驚いた」と仰っていました。

それほど日本では生成AIが、非常に幅広い領域・層から注目されていることが伺えます。

しかし一方では、生成AIの誤った活用をしたことで、悪いニュースとして取り上げられる事例も増加しています。

例えば、2023年5月には米国の弁護士が訴訟に必要な資料を「ChatGPT」を使って作成した結果、まったく存在しない架空の事例を引用したことが、問題になるニュースがありました。

出典:日本経済新聞Web版「ChatGPTで資料作成、実在しない判例引用 米国の弁護士」

また、2023年9月には日本のニュース解説メディアにおいて、自社で開発・検証中の「生成AIを用いた記事作成サービス」を利用し作成した記事が、他サイトの記事に類似しているという指摘を受け、該当記事含む49記事を削除したというニュースもありました。

出典:J-CASTニュース「49記事で日経新聞などから剽窃・盗用 ニュースサイトが謝罪『社会的・倫理的に問題』...原因は生成系AI」

どちらの例も「生成AIを活用する上で注意すべき重要なポイント」に対して、理解・対処できていないことが原因だと考えられます。

上記のような事故を未然に防ぐために、組織での生成AI利用に関しては、各組織で生成AI利用に関するガイドラインを作成して運用していると思いますが、生成AIのガイドラインには前例がないため、各組織の担当者が情報を収集しつつ手探りで作成している状況かと推測されます。

そんな中、多くの担当者が自社ガイドラインの作成時、ベースとして参考にされているのが、日本ディープラーニング協会(JDLA)が作成・公開している「生成AIの利用ガイドライン」ではないでしょうか。

2023年5月に初版が公開された本ガイドラインは、MOTEXの生成AI利用ガイドラインでも参考にしています。

今回、この「生成AIの利用ガイドライン」が2023年10月6日に改訂されたので、初版との変更点の中で組織のガイドラインの更新に影響しそうなポイントについて、確認していきたいと思います。

参考:日本ディープラーニング協会 生成AIの利用ガイドライン

JDLAの「生成AI利用ガイドライン」で改訂された、担当者が知るべき4項目

以降は、10月6日公開の「生成AIの利用ガイドライン 第1.1版【簡易解説付】」をベースに、5月に公開された同ガイドライン初版との変更点を引用、担当者が把握しておくべき「改定のポイント」を解説いたします。

変更箇所としては、全体的に「著作権」に関する項目がほとんどで、初版に比べより細かな条件や補足説明が追記されています。

憶測となりますが、今回改訂された箇所は、本ガイドラインが公開された5月以降、JDLAに多くの質問が寄せられたことを理由に、加筆修正が行われたと考えております。実際、MOTEXでも「ChatGPT活用セミナー」を開催させていただきましたが、事前質問で最も多く寄せられたのは「著作権および個人情報の管理」に関する内容でした。

それでは変更点の中でも「自組織のガイドラインの更新」に影響しそうな項目に焦点を絞って、解説していきたいと思います。

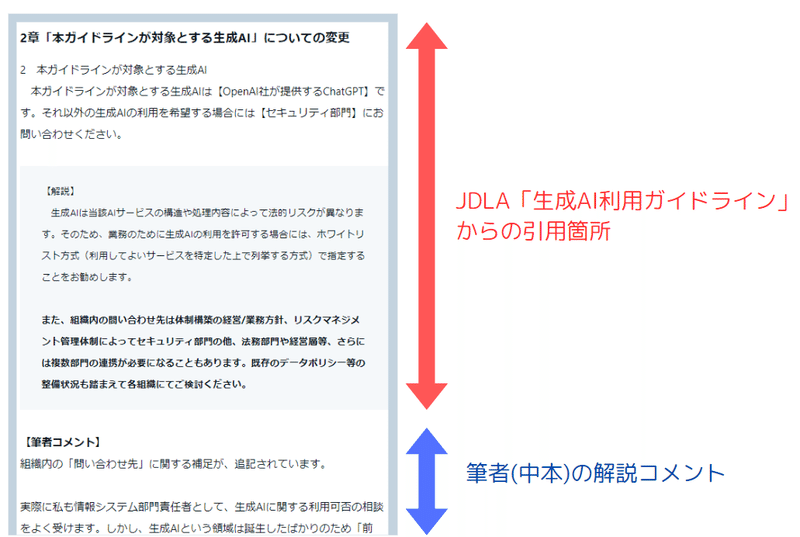

▼解説の見方

※JDLAのガイドライン本文中、改訂された箇所は「太字」で明記しています。

▼解説する章

2章「本ガイドラインが対象とする生成AI」

3章「生成AIの利用が禁止される用途」

5章「データ入力に際して注意すべき事項」より

(4)個人情報

(5)他社から秘密保持義務を課されて開示された秘密情報

2章「本ガイドラインが対象とする生成AI」についての変更

まずは、ガイドラインの第2章「本ガイドラインが対象とする生成AI」項目について、変更点をご紹介します。

--------------------- 以下、生成AIガイドラインより引用 -----------------------

2 本ガイドラインが対象とする生成AI

本ガイドラインが対象とする生成AIは【OpenAI社が提供するChatGPT】です。それ以外の生成AIの利用を希望する場合には【セキュリティ部門】にお問い合わせください。

【解説】

生成AIは当該AIサービスの構造や処理内容によって法的リスクが異なります。そのため、業務のために生成AIの利用を許可する場合には、ホワイトリスト方式(利用してよいサービスを特定した上で列挙する方式)で指定することをお勧めします。

また、組織内の問い合わせ先は体制構築の経営/業務方針、リスクマネジメント管理体制によってセキュリティ部門の他、法務部門や経営層等、さらには複数部門の連携が必要になることもあります。既存のデータポリシー等の整備状況も踏まえて各組織にてご検討ください。

--------------------------------------------------------------------------------------

▼筆者コメント

組織内の「問い合わせ先」に関する補足が、追記されています。

実際に私も情報システム部門責任者として、生成AIに関する利用可否の相談をよく受けます。しかし、生成AIという領域は誕生したばかりのため「前例」がほぼ無く、法的な解釈も定まっていないことから、答えを出すことが非常に悩ましいのが実情です。

情報システム部門(セキュリティ部門)だけでの対応には限界があるため、会社としてどこまで許可するか、どこから禁止とするか、経営層や法務部門と共に考えることが重要だと考えています。

恐らくこうした背景から、今回解説文が追加されたのではないかと思っています。

3章「生成AIの利用が禁止される用途」についての変更

続いて、ガイドラインの第3章「生成AIの利用が禁止される用途」の変更点について、見ていきます。

--------------------- 以下、生成AIガイドラインより引用 -----------------------

3 生成AIの利用が禁止される用途

当【社】では以下の用途・業務での生成AIの利用を禁止します。

【(1) ・・・】

【(2) ・・・】

【解説】

生成AIを利用する機関によっては、特定の用途での利用を禁止したい場合もあると思われます。その場合は、生成AIの利用そのものを禁止する場合と、生成AI「のみ」を用いて出力された生成物を禁止対象とするのか、明示するとよいでしょう。

たとえば、東京大学が2023年4月3日に公表した「生成系AI(ChatGPT, BingAI, Bard, Midjourney, Stable Diffusion等)について」2においては「本学では学位やレポートについては、学生本人が作成することを前提としておりますので、生成系AIのみを用いてこれらを作成することはできません。」とされています。

そのような場合は、ガイドラインにおいて一定の用途での利用を禁止することが考えられます。

--------------------------------------------------------------------------------------

▼筆者コメント

「生成AIの利用が禁止される用途」の解説部分が追記されています。冒頭に取り上げた訴訟資料やニュース記事の事故のように、生成AI「のみ」によって出力された生成物をそのまま活用すると、事故につながる可能性があります。

組織のガイドラインには、「生成AIを活用して作成した生成物は必ず人が確認すること」などの記載がされていると思いますが、人的確認の有無が曖昧になっている可能性もあります。

弊社でも「“生成AI のみ” を用いた生成物の利用を禁止する」という形に、既存のガイドラインをアップデートする予定です。

5章「データ入力に際して注意すべき事項 -

(4) 個人情報」についての変更

最後に、ガイドラインの第5章「データ入力に際して注意すべき事項」より「(4) 個人情報」「(5)他社から秘密保持義務を課されて開示された秘密情報」について、それぞれ変更点をご説明します。

--------------------- 以下、生成AIガイドラインより引用 -----------------------

(4) 個人情報

【ChatGPT】においては入力したデータが【OpenAI社】のモデルの学習に利用されることになっていますので、【ChatGPT】に個人情報(顧客氏名・住所等)を入力する場合、当該個人情報により特定される本人の同意を取得する必要があります。そのような同意取得は現実的ではありませんので、個人情報を入力しないでください。

【ただし、利用する生成AIによっては、特定の条件を満たせば個人情報の入力が適法になる可能性もあります。詳細は【セキュリティ部門】にお問い合わせください。】

【解説】

個人情報(個人データ)を生成AIに入力する行為が適法か否かは、当該生成AI内でのデータの取扱いや、当該生成AIサービス提供者が外国にある事業者なのかによっても結論が分かれ、非常に複雑です。たとえば、WEB版のChatGPTにおいてはデータ管理機能の追加により、対話履歴をオフに設定することで、学習に使われないようユーザが管理できるようになっていますが、OpenAI社は外国の第三者であるため、個人情報保護法上、あらかじめ本人の同意を得ることなく個人データの入力はできない可能性があります。

そのため本ガイドラインでは一律個人情報の入力を禁止することにしています。

一方で、OpenAI のAPIや、Azure OpenAIサービスを利用する場合には個人情報保護法上の規制をクリアできる場合もあります。そのため【ただし、利用する生成AIによっては、特定の条件を満たせば個人情報の入力が適法になる可能性もあります。詳細は【セキュリティ部門】にお問い合わせください。】と記載しています。実際には約款等の調査が必要になるため、法務部門との連携が必要になってくると思われます。

なお、2023年6月2日に個人情報保護委員会から「生成 AI サービスの利用に関する注意喚起等」が公表されています。同注意喚起別添1においては「(1) 個人情報取扱事業者における注意点」として以下の記載がなされています。

「②個人情報取扱事業者が、あらかじめ本人の同意を得ることなく生成 AI サービスに個人データを含むプロンプトを入力し、当該個人データが当該プロンプトに対する応答結果の出力以外の目的で取り扱われる場合、当該個人情報取扱事業者は個人情報保護法の規定に違反することとなる可能性がある。そのため、このようなプロンプトの入力を行う場合には、当該生成 AI サービスを提供する事業者が、当該個人データを機械学習に利用しないこと等を十分に確認すること。」

当該注意喚起をどのように読むのか(入力された個人データが応答結果の出力生成の目的のみで取り扱われる場合は個人データの「提供」に該当しないのではないか等)は様々な意見があるところですが、少なくとも、あらかじめ本人の同意を得ることなく入力された個人データが、生成AIサービス提供者において機械学習に利用される場合は、当該入力行為が個人情報保護法の規定に違反することとなる可能性がある点に留意する必要があります。

--------------------------------------------------------------------------------------

▼筆者コメント

生成AIを自組織で活用する上で、著作権と共に関心が高い内容は「個人情報の扱い」ではないでしょうか。

最新のガイドラインでは、個人情報保護委員会が2023年6月2日に発表した「生成AIサービスの利用に関する注意喚起等」を受けて、個人情報の取り扱いに関する内容が多数追記されています。

個人情報保護委員会の注意喚起では、主に「個人情報取扱事業者」「行政機関等」「一般の利用者」の3分野に対して記載されていますが、一般の利用者に対しての内容はJDLAのガイドラインと類似した内容となります。

個人情報取扱事業者や行政機関等の関係者は、個人情報保護委員会の「注意喚起」内容も踏まえた、自組織のガイドラインのアップデートが必要と感じます。

5章「データ入力に際して注意すべき事項 -

(5)他社から秘密保持義務を課されて開示された秘密情報」についての変更

--------------------- 以下、生成AIガイドラインより引用 -----------------------

外部事業者が提供する生成AIに、他社との間で秘密保持契約(NDA)などを締結して取得した秘密情報を入力する行為は、生成AI提供者という「第三者」に秘密情報を「開示」することになるため、NDAに反する可能性があります。

そのため、そのような秘密情報は入力しないでください。

【解説】

①生成AI提供者が入力データに監視目的での限定されたアクセスしかしない、あるいは一切アクセス・保存しない場合において、②組織が秘密情報の利用目的として定められている目的のために生成AIに秘密情報を入力(プロンプトエンジニアリングのために利用することも含む)して分析・生成する行為については、NDAに違反しないでしょう。一方、大規模言語モデル(LLM)の多くは入力データが学習に利用されますので、NDA違反を構成する可能性が高いと思われます。

また、NDAの解釈によっては第三者の管理下に置くこと、たとえば、GCPやAWSといったクラウドサービス上にデータを置くこと自体が違反とされるケースも見受けられます。そのため、本ガイドラインでは一律入力を禁止しています。

--------------------------------------------------------------------------------------

▼筆者コメント

「秘密保持契約(NDA)を締結して取得した情報の取り扱い」に関しての注意事項が追記されています。

業務効率の向上や新たな価値創出を目的に、生成AIを活用するケースは今後増加すると考えられます。また、Google や Microsoft 、Amazon Web Services などの各クラウドサービス提供事業者も、自社プラットフォーム上での各種AIサービスの提供を強化しています。

一方で、これらの活用においては、事前に利用の可否をNDA締結者同士で会話し、合意を得ておく必要があるという点に注意が必要です。

締結済みのNDA全てを締結し直すことは難しいかもしれませんが、各社で用意しているNDAのひな形に、生成AI活用に関する条文を追加する、あるいは生成AIガイドラインにNDA締結時の注意事項を追加することを検討する必要があるでしょう。

参考:個人情報保護委員会「生成AIサービスの利用に関する注意喚起等について(令和5年6月2日)」

まとめ

いかがでしたでしょうか?生成AIの活用が進む一方で、誤った理解・活用により事故につながるケースも増えてくると思います。

こういった事故を少しでも防ぐために、生成AIに関するガイドラインは、世の中や自社の状況に合わせて定期的にアップデートしていくことが重要となります。

また、ガイドラインのアップデートが目的ではなく、ガイドラインを通じて組織に所属する全員が、内容を理解して正しく安全に生成AIを活用することが大切です。そのため、ガイドラインのアップデートと合わせた社内の勉強会やトレーニング等を通じて、最新の情報への理解を進めていくことこそ重要だと考えています。

生成AI活用に関するルールは、まだしばらくは変化が激しい状態が続きますが、今後も「ガイドラインの改訂」や「大きな注意点」が出てきた際、引き続き当noteを通じて情報発信していきます。

本記事が少しでも、皆様の生成AI活用につながると幸いです。