OpenAI の ファイチューニングAPI の新機能

以下の記事が面白かったので、簡単にまとめました。

・Introducing improvements to the fine-tuning API and expanding our custom models program

1. ファインチューニングAPI

2023年8月、GPT-3.5の「ファインチューニングAPI」をリリースしました。ファインチューニングは、特定のタスクに対するモデルの既存の知識と機能を強化するのに役立ちます。

ファインチューニングの一般的な使用例は、次のとおりです。

・特定のプログラミング言語でより良いコードを生成

・特定の形式でテキストを要約

・ユーザーの行動に基づいてパーソナライズされたコンテンツを作成

・Indeedの活用例

世界的な求人マッチングサービスであるIndeedは、採用プロセスを簡素化したいと考えています。その一環として、求職者にパーソナライズされた推奨事項を送信し、スキル、経験、好みに基づいて関連する求人を強調表示する機能を開始しました。彼らはGPT-3.5 Turboをファインチューニングして、より高品質でより正確な説明を生成しました。その結果、プロンプト内のトークン数を80%削減することで、コストと待ち時間を改善することができました。

2. ファインチューニングAPI の 新機能

2024年4月4日、ファインチューニングAPIに新機能が導入されました。

・エポックベースのチェックポイント作成 : 各学習エポック中に、完全にファインチューニングされたモデルチェックポイントを1つ自動的に生成します。これにより、特に過学習の場合に、その後の再学習の必要性が軽減されます。

・比較プレイグラウンド : モデルの品質とパフォーマンスを比較するための新しい並列プレイグラウンドUIにより、複数のモデルの出力を人間が評価したり、単一のプロンプトに対してスナップショットをファインチューニングしたりできるようになります。

・サードパーティ統合 : サードパーティ プラットフォームとの統合のサポート (Weights and Biasesから開始) により、開発者は詳細なファインチューニングデータをスタックの残りの部分と共有できるようになります。

・包括的な検証メトリクス : サンプリングされたバッチではなく検証データセット全体にわたって損失や精度などのメトリクスを計算し、モデルの品質に関するより良い洞察を提供します。

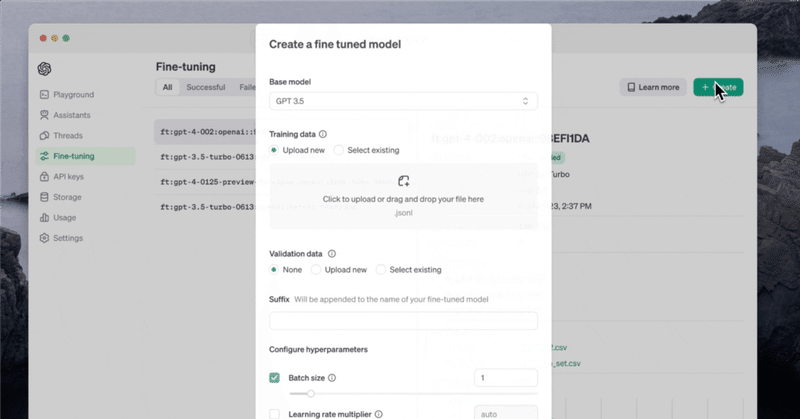

・ハイパーパラメータ設定 : ダッシュボードから利用可能なハイパーパラメーターを設定できるようになりました。

・ダッシュボードのファインチューニングの改善 : ハイパーパラメーターの設定、より詳細な学習メトリクスの表示、過去の履歴からのジョブの再実行の機能が含まれます。

3. カスタムモデルプログラムの拡大

3-1. アシストファインチューニング

カスタムモデルプログラムの一環として、「ファインチューニング支援サービス」を正式に発表します。「アシストファインチューニング」は、追加のハイパーパラメータや様々なパラメータ効率的ファインチューニング手法など、ファインチューニングAPIを超えるテクニックをより大規模に活用するための、OpenAIの技術チームとの共同作業になります。

・SK Telecomの活用例

韓国の電気通信事業者である SK Telecom は、最初は顧客サービスに重点を置き、電気通信分野のエキスパートとなるようにモデルをカスタマイズしたいと考えていました。彼らは OpenAIと協力してGPT-4をファインチューニングし、韓国語での通信関連の会話におけるパフォーマンスを向上させました。GPT-4と比較して、会話の要約の品質が35%向上し、意図認識の精度が33%向上し、満足度スコアが3.6から4.5 (5点満点) に向上しました。

3-2. カスタム学習モデル

場合によっては、組織は、自社のビジネス、業界、ドメインを理解する専用のモデルを一から学習する必要があります。 完全にカスタム学習されたモデルは、学習プロセスをカスタマイズすることにより、特定のドメインから新しい知識を注入します。完全にカスタム学習されたモデルで成功を収めている組織は、多くの場合、大量の独自のデータ (数百万のサンプルまたは数十億のトークン) を保有しており、これらのデータを使用して、モデルに新しい知識や、非常に特殊なユース ケース向けの複雑でユニークな動作を教えたいと考えています。

・Harveyの活用例

弁護士向けのAIネイティブ法律ツールであるHarveyはOpenAIと提携して、カスタム学習された判例法用のLLMを作成しました。財団モデルは推論には優れていましたが、訴訟履歴や法律業務に必要なその他の知識に関する広範な知識が不足していました。プロンプトエンジニアリング、RAG、ファインチューニングをテストした後、Harveyはチームと協力してモデルに必要なコンテキストの深さを追加しました。これは100億トークン相当のデータに相当します。OpenAIのチームは、ドメイン固有の学習プロセスのカスタマイズ、弁護士の専門家のフィードバックの組み込みに至るまで、モデル学習プロセスのすべてのステップを修正しました。結果として得られたモデルでは事実に基づく回答が83%増加し、弁護士は97%の確率で GPT-4 よりも高評価でした。

4. モデルのカスタマイズの次のステップ

将来的には、大多数の組織が、業界、ビジネス、ユースケースに合わせてカスタマイズされたモデルを開発すると考えられます。あらゆる規模の組織がパーソナライズされたモデルを開発して、AI実装によるより有意義で具体的な効果を実現できます。重要なのは、ユースケースの範囲を明確にし、評価システムを設計および実装し、適切な手法を選択し、モデルが最適なパフォーマンスに達するまで時間をかけて反復する準備をしておくことです。

OpenAIを利用すると、ほとんどの組織はセルフサービスのファインチューニングAPI を使用して、有意義な結果をすぐに確認できます。モデルをより深くファインチューニングしたり、新しい知識をモデルに組み込んだりする必要がある組織にとって、カスタムモデルプログラムは役に立ちます。

モデルのファインチューニングを開始するには、ファインチューニングAPI ドキュメントを参照してください。モデルをカスタマイズの詳細については、OpenAIへのお問い合わせになります。

この記事が気に入ったらサポートをしてみませんか?