Sound Analysisのビルトイン音声分類器の性能を試す #WWDC21

本記事では、Sound Analysisのビルトイン音声分類器(Built-in Sound Classifier)を実機で使用してみて、分類の精度や処理速度といった性能を検証してみる。

なお、ビルトイン音声分類器の詳細はこちらの記事を参照:

要約:

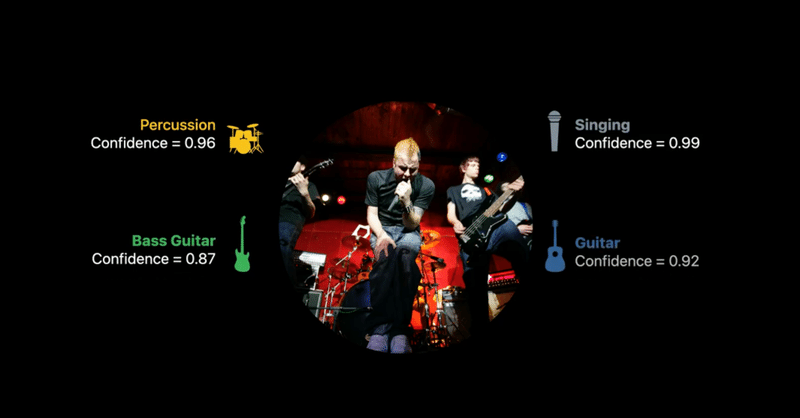

・Sound Classifier/Sound Classificationはディープラーニングで音声を識別するもの

・これまでは自分でトレーニングデータセットを用意してCreate MLでモデルの学習から行う必要があった

・iOS 15で、システム組み込み(built-in)のモデルが利用できるようになった🎉

検証方法

Chopperという個人開発アプリで、Create MLで学習させたカスタム音声分類モデルを使用している。

10年ぶりに個人開発アプリをリリースしました🎉AIで人の声を抽出して動画の無音を自動でカットするアプリです。デザインは @daitorii さん。https://t.co/ELIDVJW8a2 pic.twitter.com/eo8VlzysXB

— Shuichi Tsutsumi (@shu223) May 2, 2021

この自作モデルは、シンプルに"speech"(発話)と"other"(それ以外)を分類する。

この作例のようにバチッとうまくいくケースもあるが、

before / after の作例はこちら。従来の無音カットだと物音やガサゴソ音が入るだけで無音ではないと判定されていたような箇所も、「人の声」を判定することで綺麗に除去できています。https://t.co/NO2Po0krz9

— Shuichi Tsutsumi (@shu223) May 2, 2021

実際のところうまくいかないケースもある。

昨日の記事でビルトイン音声分類器も"speech"や"silence"といったクラスをサポートしていることがわかったので、

このアプリの自作モデルをビルトイン分類器で置き換えてみて、元のカスタムモデルでうまくいった(動画の)音声/うまくいかなかった音声について適用してみた。

### 精度をどのように検証するのか

このChopperというアプリケーションはAIで(Sound Classifierを用いて)発話区間を検出し、そうではない区間をカットする、というもの。

そのカットすべき区間だけを集めた音声を出力し、人間が聞く(自分で聴いてみる)ことで、どの程度「非発話区間がきちんとカットできているか」を検証できる。

ここから先は

#WWDC21 の勉強メモ

堤がWWDC 2021およびiOS 15についてセッションやサンプルを見つつ勉強したことを記事にしていくマガジンです。NDAの都合上、Ap…

最後まで読んでいただきありがとうございます!もし参考になる部分があれば、スキを押していただけると励みになります。 Twitterもフォローしていただけたら嬉しいです。 https://twitter.com/shu223/