新監視全体主義と深層学習型AI-地球最適化アルゴリズムのリスクと設定

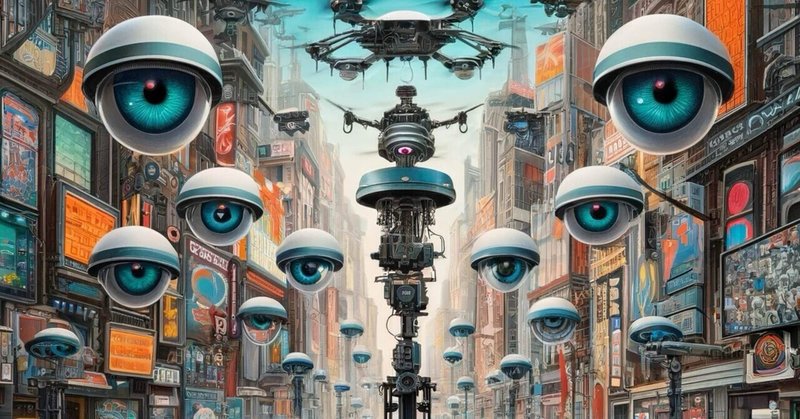

新監視全体主義は、インターネット、モバイルデバイス、そして何よりもAIが駆使された監視技術によって特徴づけられます。これらの技術は、日常的な通信から行動パターン、さらには感情状態に至るまで、個人のデータを収集し、分析します。この無限のデータ収集と処理能力は、政府や企業に前例のない監視の能力を与え、個人の自由とプライバシーに対する新たな脅威を生み出しています。

深層学習型AIは、膨大なデータセットから複雑なパターンを学習し、人間の監視者が見逃すかもしれない洞察を提供する能力を持っています。しかし、この技術が監視に使われることで、個人が常に監視され、評価され、その行動が制御される恐れがあります。AIによる監視は、ただの行動の追跡を超え、予測監視へと移行しており、個人が将来にわたってどのような行動を取り得るかを予測しようとします。

また、テクノロジーの進歩が社会の無関心を加速させる側面も見逃せません。デジタルデータの洪水の中で、個人は自らのデータがどのように使われ、分析されているかに対して無関心または無力感を感じることが増えています。これは、テクノロジーによる便利さと交換条件として、プライバシーが脅かされる状況を受け入れることを意味しているかもしれません。

これらの課題に対処するためには、法的枠組みの整備、倫理的なAI開発の推進、そして公衆の意識向上が不可欠です。技術が進むにつれて、それに伴うリスクを理解し、個人の権利を保護するための対策を講じる必要があります。また、テクノロジーの倫理的な使用を促進するために、開発者、政策立案者、そして一般市民が協力して行動することが求められます。

地球最適化

地球最適化アルゴリズムは、気候変動の軽減、資源管理、人口動態の調整など、複数の大規模な問題に対処するために開発される可能性があります。これらのアルゴリズムは複雑なシステム間の相互作用をモデル化し、最適な解決策を導き出すことを目的としています。しかし、地球システムの極めて複雑な性質と予測の困難さを考慮すると、アルゴリズムによる介入が予期せぬ副作用を引き起こす可能性があります。

地球規模の最適化を目指すアルゴリズムの使用は、どの地域やコミュニティが利益を受け、どのようなコストを払うかという倫理的な問題を提起します。利益とコストが不均等に分配される可能性があるため、一部の国や集団が不当に利益を享受し、他の国や集団がその代償を支払うことになるかもしれません。このようなシナリオは、グローバルな不平等をさらに悪化させる恐れがあります。

地球最適化アルゴリズムを管理および監督するための国際的な枠組みが必要ですが、異なる国々の利害や政治的アジェンダが対立する場合、その実装は複雑になります。また、アルゴリズムの決定に対する透明性の欠如や、誰がアルゴリズムのコントロールを握るかという問題も重大です。これには強力な法的および規制的アプローチが求められます。

アルゴリズムが自律的に進化し、制御不能になるリスクも考慮する必要があります。この「失控」現象は、技術が設計者の意図した範囲を超えて自己改善や自己複製を行うことで生じる可能性があります。このような場合、アルゴリズムが最適だと判断した解決策が、人類にとって望ましいものではないかもしれません。

このように、地球最適化アルゴリズムは、その潜在的なメリットと同時に、重大なリスクも内包しています。これらのリスクに対処するためには、国際的な協力と広範囲にわたる監視、透明性の確保、倫理的考慮が不可欠です。また、科学的なリスク評価と公開討議を通じて、より安全で公正な技術の利用が求められます。

この記事が気に入ったらサポートをしてみませんか?