美術鑑賞にGoogleレンズは使える?

展覧会で観賞をする際、「困ってしまう」のが文字資料。

例えば回顧展であればその人の著書、また同時代に刊行されていた雑誌であったりなんなりがガラスケースの中に展示されていることがある。作品リスト上は、作品番号とは別に「資料1」「資料2」などという番号を振られていたりもする。

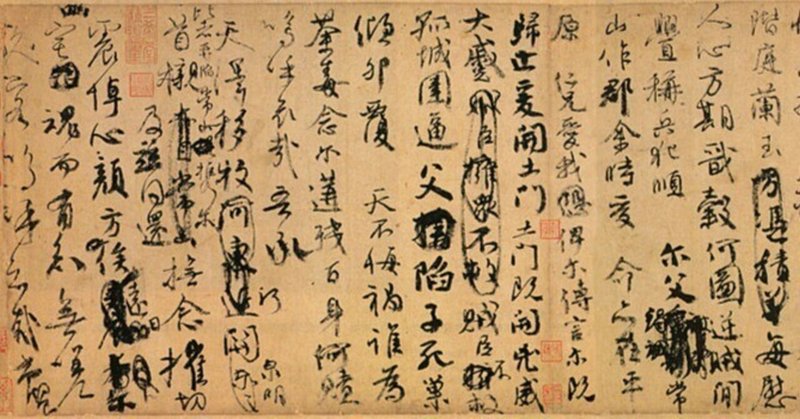

私にも虚栄心というものがあり、いかにもそれらしく腕を組み、マスオさんみたいな知ったかぶり全開の表情でその「資料1」を覗き込む。しかし、そこに何が書いてあるのかが理解できない。私の場合は近代以降の日本語、あと英語が精一杯で、毫も理解することのできないフランス語、漢字が並び倒す中国語を前に(一体何が書いてあるんだか…)となってしまう。

そして、そんな40男を尻目に、フランス人や中国人観光客がそんな「資料1」を見て、ちゃんと理解している様子で作品を凝視している。なんならパートナーや同級生などと文面についてあーだこーだと議論をしていたりもする。

もちろんこれは一方的な僻みで、彼らも彼らで、私達の理解する日本語の資料を意味不明のまま見つめているのかもしれない。

そういうとき、「Googleレンズの翻訳機能が使えたら…」と思ったことが何度かある。理想はそういった文字資料の翻訳を展覧会側で制作し、載せてくれればと思うが、さすがにそれは展覧会側の負担になりすぎてしまう(展覧会によってはこういった資料を訳出し、パネルで掲載していることもあるにはあるが、全ての展覧会についてこれを期待するわけにもいかない)。

先日、マリー・ローランサン展を観にアーティゾン美術館に出かけた際、それを実践する機会に恵まれた。ローランサン展は作品によって写真撮影OK/NGが分かれていて、文字資料に関しては確か原則OKだったと記憶している。カメラをかざして、その場でリアルタイムに翻訳をすることもできるが、これだと他の方の通行の邪魔にもなる。そこで写真を一度撮影し、ソファ休憩をしている時にGoogleレンズを使って翻訳してみた。

こうして見ると、説明文であればなかなかきちんと書けていて、あとは年譜などと照らし合わせればより重層的な理解をすることも可能になる。一方でその真逆である詩の場合は、人間の翻訳家でも苦戦すると言われるように、コンピューターもあからさまに苦戦している。ただニュアンスは伝わるところもあり、当初のマスオさん状態よりはマシにはなっているのかなとも思う。例えば一度英語に訳出するなどすれば、より正確性の高いニュアンスを掴み取れるのかもしれない。

このほか、Googleレンズであれば画像検索を使えば絵画の作品情報を調べる、なんていうこともできる。仮に作品情報に関するパネルを撮り損なったとしても、ネットに情報さえありさえすれば後で調べることは可能である。

この文章を書くために今、少し使ってみただけでもその便利さに軽い衝撃すら受けてしまっていたが、もちろん課題もある。

まず写真撮影NGの美術館・作品では使えない。画像を残さないまでも、そういった作品にスマートフォンのカメラをかざす姿はさすがにどうかという気がする。各人にレンズ専用のスマートフォン状のデバイスを貸すという方法はあるかもしれないが、翻訳の質が安定しない以上、そういうものを美術館が提供して良いものか、という疑問も残る。プログラミング、レンタル等のコストもかかるだろうし、それだったらむしろ訳出してしまったほうが安上がりかもしれない。

また、手書きに対応ができないことも考えられる。文字認識などにおいても、「し」のつもりで書いたものが「L」などと誤解されることはよくあることだ。日本語(母語)であればまだ前後の文脈から正しい文字を推測することはできるが、知らない外国語でそれをやられたらお手上げになってしまう。

とは言え、Googleレンズや、それに付随する画像検索機能や翻訳機能が、よりアカデミックな部分に拡充してくれたらなと思う。特にくずし字や楔形文字みたいな古の言葉にGoogleが対応できるようになってきたら、美術鑑賞の世界が劇的に変わる可能性もある。

もちろんそれは良いことばかりではなく、たとえば語学学習に対する意欲を削ぐなど、教育上のリスクもあるかもしれない。ただ、鑑賞者の言語能力に依存されない環境づくり、「言葉の壁」がなくなっていくことは決して悪いことではないんじゃないかと考えている。

この記事が気に入ったらサポートをしてみませんか?