ついに脳の情報から音声・表情を可視化

以前から脳と機械をつなげるBMI(Brain Machine Interface)が、さらなる進歩を遂げていると感じる記事を見つけました。

BMIの基礎情報については過去記事の引用にとどめておきます。

上記記事内に埋め込まれたYoutube動画をみたほうが分かりやすいと思います。

もともと以前より、脳の動きをfMRIなどを使って動的にデータ解析し、そこから言語化する実験と実証はよく耳にしました。

ただ、そこではやはりテキストチャットに閉じたインタフェースでした。(あくまで見つけた範囲内では)

今回はそれをマルチ化しており、音声はなんとなくわかるのですが、興味深いのは表情を視覚的に表現しようとしている点です。

ようは、より自然に近い対話へ近づいているということです。

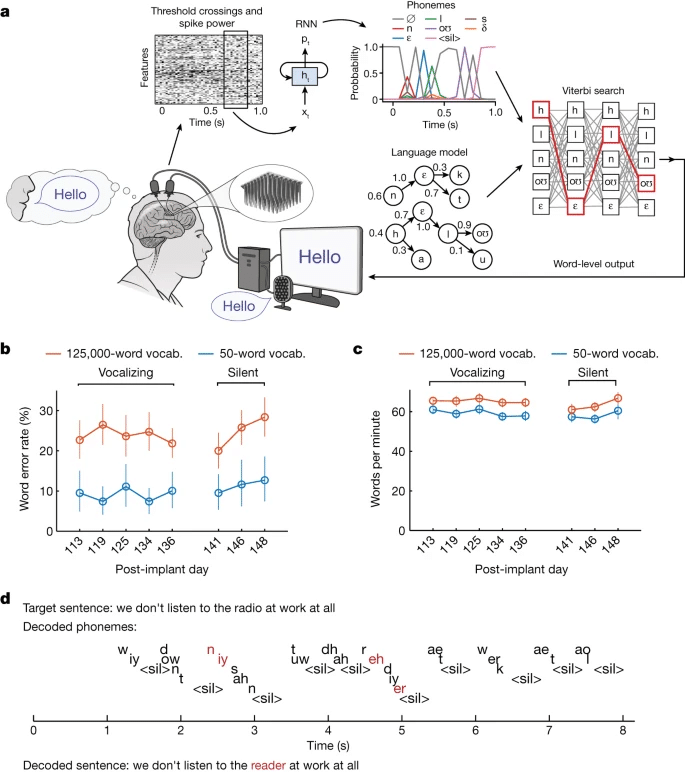

こちらによると、50 語の語彙で 9.1% の単語誤り率を達成しました (従来より誤り率 が2.7 倍現象)。125,000 単語の語彙で 23.8%で、これも従来よりも相当改善した成果のようです。

あとは対話する時間ですが、大体1分間160ワードを記録しています。

これは自分でその言葉でコントロールして話せばわかりますが、ゆっくりしゃべるペースに近いのではないでしょうか?

上記図でも一部ネットワークの図がありますが、ここでもAIが主役級の活躍を見せています。

第三次AIブームの火付け役深層学習、その中でも時系列処理に強いRNNを解析に使っています。

余談ですが、RNNは相当コンピュータリソースを食うため、それを改良に改良を重ねたのが、今話題のChatGPTの源流にあたるTransformerです。

このあたりは簡単に過去にもふれたので引用しておきます。

上記の引用記事では、タイトルのとおりChatGPTの由来よりは、それが基礎科学の分野に色々と波及する可能性に触れています。

今回もまさに神経科学の領域での大きな飛躍を下支えしています。

ずれているかもしれませんが、今回は音声化のため、音の要素(音素?)の解読もAIを使って行っています。

となると、もしかしたらそもそも音の基礎科学にも貢献しないかな?と無邪気に感じました。

そして、今回の記事では詳細までは追いかけられませんでしたが、表情との相関性が興味深いです。

今回の研究とは関係ないですが、口腔の動きをAIで解析してヘルスチェックするサービスは日本でも登場しています。

こういった生活に彩を与えるサービスもあれば、基礎科学の底上げにも貢献する、AIはまさに科学のエネルギーの役割を担っていると改めて感じた次第です。

この記事が気に入ったらサポートをしてみませんか?